Bei einem Treffen bei einem Automobil-Kunden ist mir klar geworden, dass man den von der Automobilindustrie erträumten Scheinwerfer mit Hilfe der segmentierten LED-Chips tatsächlich bauen könnte.

Dazu bräuchte es sehr viele kleine Segmente auf einem LED-Chip, die alle separat voneinander ansteuert werden – über 25.000 Stück. Aber es ist natürlich unmöglich, zu jedem einzelnen Segment – oder Pixel – ein Kabel hinzuziehen. Auch mit kleinen Drähtchen funktioniert das nicht, das ist alles einfach viel zu viel und viel zu klein. Zudem würde man das Licht durch die Drähte abschatten. Dafür brauchten wir eine Lösung.

Stefan Grötsch

Ich hatte mich mit dem Thema Videoprojektion auseinandergesetzt. Die Herausforderung dort war, dass wir mit unserer LED nur einen passiven Licht-Modulator beleuchteten, der so funktioniert: Man nimmt eine Lichtquelle, die immer mit maximaler Helligkeit an ist, um den Modulator zu beleuchten. Dieser schattet dann das unerwünschte Licht pixelweise ab. So entsteht das Videobild aus hellen und dunklen Bildpunkten. Das heißt, ich erzeuge erst einmal das ganze Licht und muss dann das effizient erzeugte Licht teilweise wieder vernichten. Die weißen Bildpunkte bleiben an, für die schwarzen Bildpunkte wird das Licht weggefiltert. Dieses pixel-feine Abfiltern wird in einem LCD gemacht, oder auch durch ein Mikrospiegel-Array.

Eine schöne Lösung ist das nicht, denn sie hat gleich einige Nachteile: Zum einen hat man die Energie für die gesamte Lichterzeugung reingesteckt, dann nur das wenige Nutzlicht rauszunehmen, ist relativ ineffizient. Denn der Energiebedarf ist dadurch höher als notwendig. Zum anderen wird das Licht, das im Bild gerade nicht gebraucht wird, zu Wärme, die ich aus den kleinen Bauteilen wieder abführen muss. Das schränkt mich darin ein, wie ich so einen Videoprojektor designen kann. So kam es zur Überlegung, wie toll das wäre, wenn man LED-Pixel direkt auf dem Treiber hätte. Dann würden nur diejenigen Pixel leuchten, die im Bild gerade gebraucht werden. Das war eine Idee, die wir Anfang 2007 mit den Kollegen in der Vorfeldentwicklung besprachen. In der Folge wurden dann erste Versuche zu Pixel-LEDs gestartet.

Ein anderer Ansatz, eine steuerbare Lichtverteilung zu ermöglichen, war damals, mehrere LEDs im Gehäuse auf eine Platine zu montieren und die dann eben separat ein- oder auszuschalten. Dieser althergebrachte Ansatz hat seine Grenzen. Irgendwann wird das auf einer Leiterplatte zu komplex, alle Leitungen zu der LED hinzuführen und wieder rauszuführen. Irgendwo muss auch die Leistungsversorgung und die Steuerelektronik untergebracht werden. Man kann vielleicht 50 oder sogar 100 LEDs mit Gehäuse auf eine große Leiterplatte montieren. Aber dann wird die Leiterplatte schon sehr komplex und bei noch mehr LEDs ist eine Schallmauer erreicht, dann ist das in den sogenannten diskreten Schaltungen nicht mehr sinnvoll möglich.

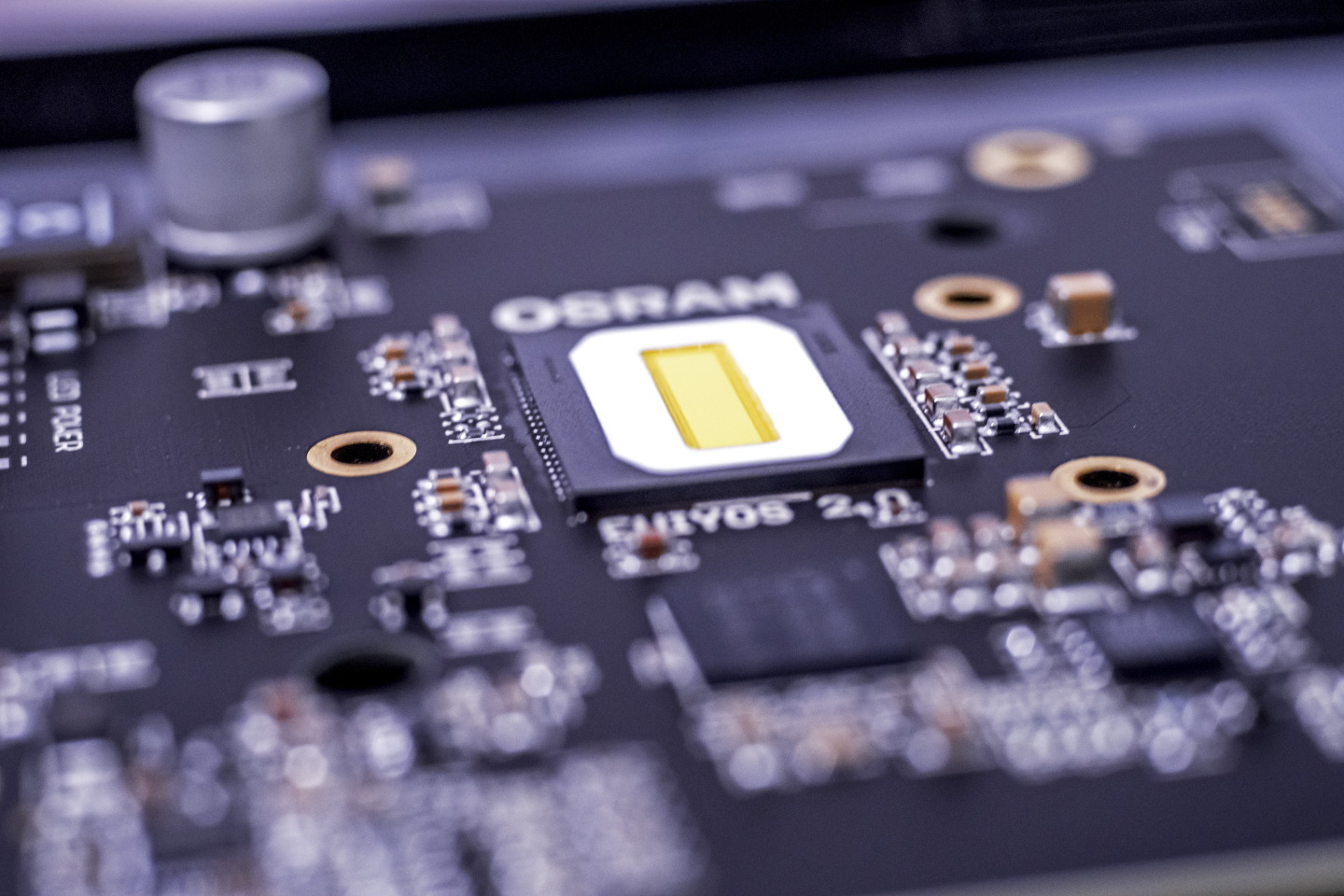

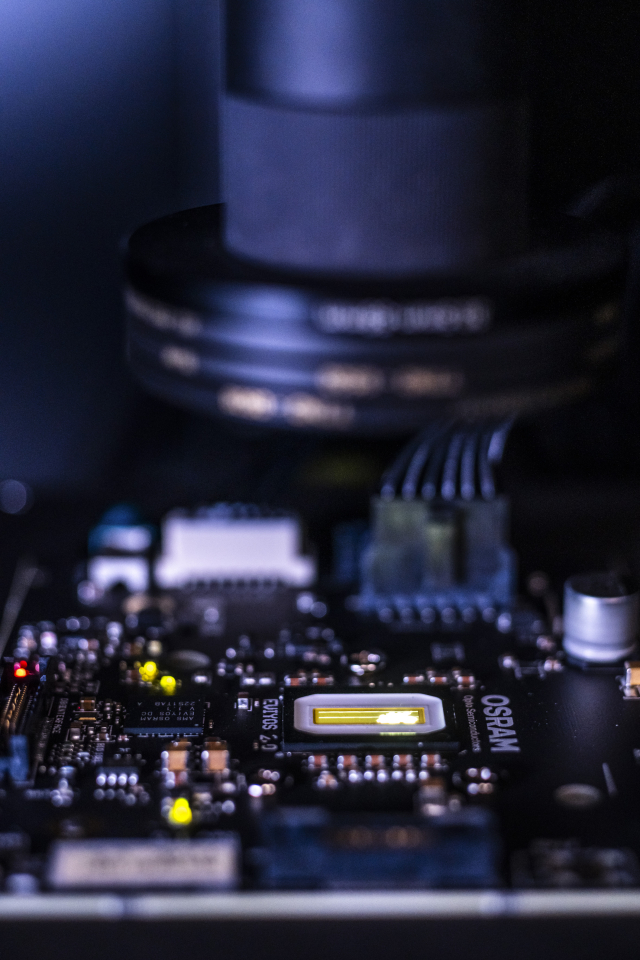

Der disruptive Schritt ist die Vorwärtsintegration - also den Treiber-Chip mit dem LED-Chip in der Verbindungstechnologie zusammenzubringen. Das macht es möglich, die Anzahl der Pixel zu erhöhen. Ein erster Schritt waren 1.000 Pixel auf einem LED-Chip, jetzt haben wir 25.600. Und das Fernziel sind Full-HD-Systeme, vielleicht sogar noch darüber hinaus.

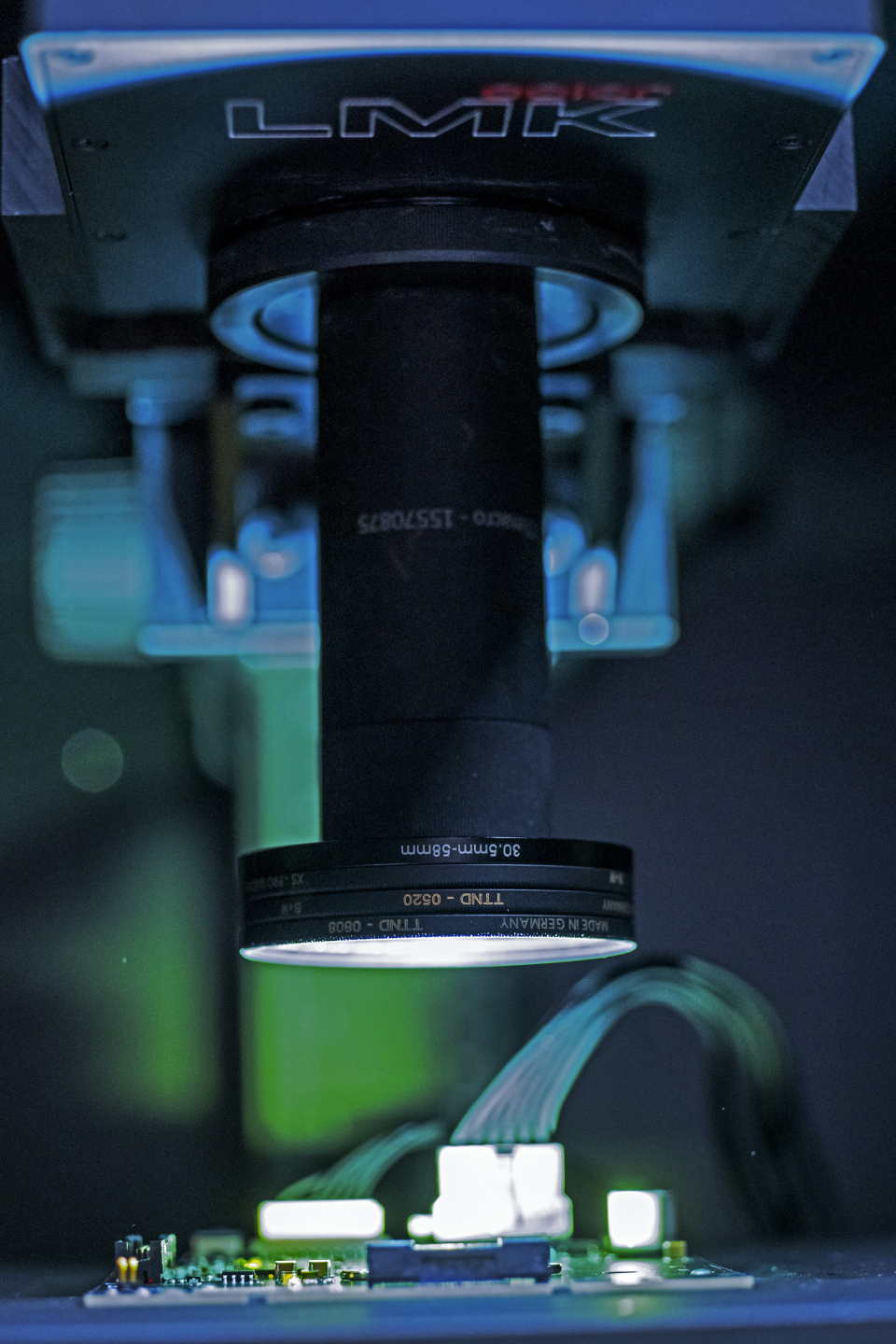

Dr.-Ing. Hermann Oppermann

Man kann sich natürlich fragen, warum muss das denn so klein werden? Ein Autoscheinwerfer ist ja eigentlich recht groß. Hat man da nicht ausreichend Platz, um Hunderte oder Tausende von LED-Bauelementen einzubauen? Grundsätzlich schon, aber das Problem ist die Optik: Für jede einzeln eingebaute LED muss eine Optik genau justiert werden, um die Muster auf die Straße zu projizieren. Die Vielzahl von einzelnen Optiken ist nicht nur teuer, die Justage ist zudem extrem aufwändig. Bei einer Lichtmatrix, die mit pixelierten LEDs hergestellt wird, sind die Positionen der Pixel halbleitergenau definiert. Der ganze Scheinwerfer wird so zu einem „Videoprojektor“ und je größer das Ausgangsbild ist, also je größer die Matrix mit den LEDs ist, desto aufwändiger wird die Optik, die man braucht, um ein scharfes Bild zu projizieren. Und Optiken sind teuer. Daher ist der Wunsch da, die Leuchtmatrix möglichst klein zu halten.

Welches Problem löst diese Innovation, das bis dahin noch nicht lösbar war?

Dr. rer. nat. Norwin von Malm

Die Technologie des Digitalen Lichts löst das Problem, beliebig definierbare, und zwar durch ein digitales Signal definierbare Lichtverteilungen auf einen LED-Chip zu bringen. Bis dato konnte man LEDs einschalten und ausschalten oder vielleicht ein bisschen heller oder dunkler machen, mehr nicht. Zudem waren Schaltungen von mehreren LEDs auf einer Platine alle relativ groß. So, wie man sich in den 50er-Jahren elektronische Schaltungen vorgestellt hat. Da wurden Transistoren, Widerstände, Spulen auf eine große Platine montiert und alle diese diskreten Bauteile mit Kabeln oder Leiterbahnen verbunden. Der Schritt des Digitalen Lichts ist jetzt vergleichbar mit dem Schritt von dieser Platine mit den Transistoren hin zu einem integrierten Schaltkreis auf einem Stückchen Silizium, wo das alles in einem winzigen Bruchteil der Größe geht.

Wie gesagt, ist die Ansteuerung vieler Tausend LED-Pixel zur Erzeugung der definierbaren Lichtverteilung mit vorher bekannten Methoden nicht mehr möglich. Der Strom für diese Matrix aus LED-Pixeln muss also direkt von unten kommen, direkt unter dem Pixel. Das kann man erreichen, indem man die LED segmentiert, also kleine Pixel daraus macht. Und diese Pixel werden direkt auf eine elektronische Ansteuerschaltung gesetzt, so dass jeder Pixel seine eigene Stromquelle genau darunter hat. Das hatten wir damals mit den Automobilkollegen diskutiert und gesagt: „Das wäre die Lösung für so einen Autoscheinwerfer."

In Bezug auf die Technik und die Kombination der verschiedenen neuen Elemente: Was müsste an der Chip-Architektur geändert werden, um so einen neuen Ansatz zu ermöglichen?

Dr. rer. nat. Norwin von Malm

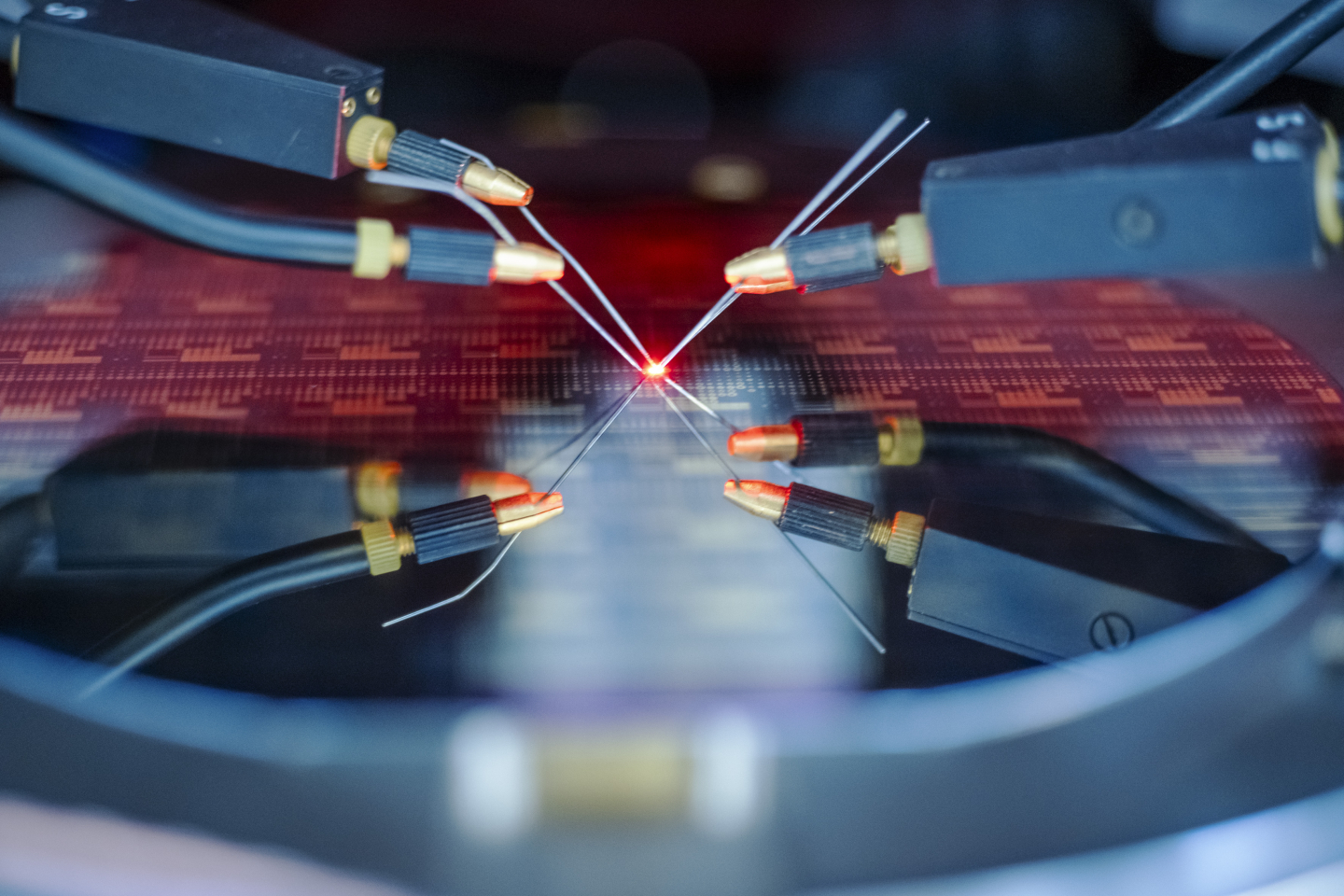

Die erste Aufgabe war, die LED zu segmentieren, sprich die Bereiche auf der Chip-Oberfläche voneinander abzugrenzen. Und zwar nicht nur elektrisch, sondern auch optisch. Diese Segmente oder Pixel müssen zum einen klein sein und zum anderen müssen es sehr viele sein. Die zweite Aufgabe war, die Kontaktierung umzustellen: normalerweise gibt es bei einer LED eine p-Seite und eine gegenüberliegende n-Seite. Das sind prinzipiell die Stellen, an denen man elektrisch kontaktieren muss, damit die LED leuchtet. Daher ist normalerweise der eine Kontakt auf der einen Seite und der andere Kontakt auf der anderen Seite. Das ist für die von uns beschriebene Anwendung aber nicht hilfreich, da die LED von unten angesteuert werden soll. Man braucht daher beide Kontakte auf der Unterseite. Das erfordert eine komplett neue LED-Architektur.

Darüber hinaus brauchte es eine strukturierte Verbindungsschicht, die es erlaubt, jedes LED-Pixel mechanisch, thermisch, elektrisch an die elektronische Ansteuerschaltung anzukoppeln. Und natürlich noch eine passende Ansteuerschaltung.

Konkret für den Scheinwerfer ergab sich zudem noch eine andere Herausforderung: Eine LED hat immer nur eine Farbe, unsere war blau. Wir wollen aber im Scheinwerfer weißes Licht erzeugen - und weißes Licht besteht aus mehreren Farben. Um weißes Licht zu erzeugen, bringt man deshalb einen Leuchtstoff auf, der einen Teil des blauen Lichts absorbiert und in gelbes Licht umwandelt. Und diese Mischung aus durchtretendem blauen Licht und dem gelben Licht erzeugt dann den Weiß-Eindruck. Das ist bei Standard-LEDs kein Problem. Man bringt diese Leuchtstoffschicht obendrauf und dann wird das Licht weiß.

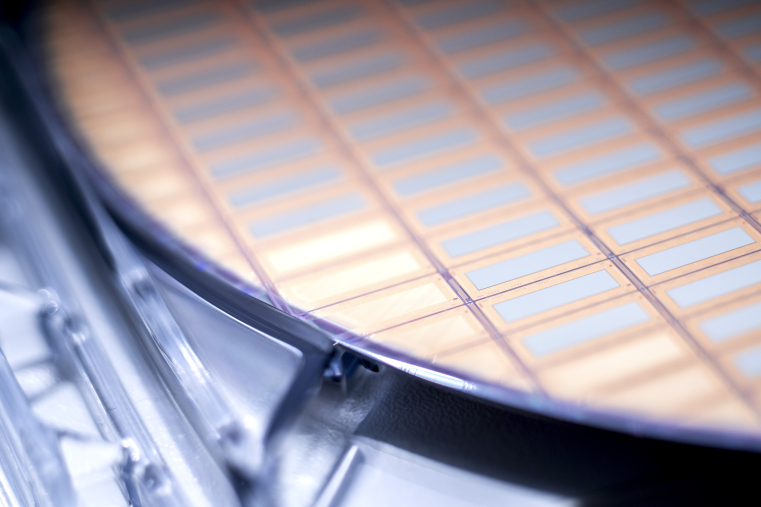

LEDs werden auf einem Wachstumssubstrat, einem Wafer, hergestellt. Und wenn man den LED-Wafer mit der elektronischen Treiberschaltung verbindet, dann ist dieses Wachstumssubstrat immer noch obendrauf.

Das ist zwar transparent, würde also eigentlich nicht stören, aber dieses durchsichtige Wachstumssubstrat sorgt dafür, dass ich dann keinen Pixelkontrast mehr habe, wenn ich diese Leuchtstoffschicht obendrauf bringe. Wenn ich also ein Pixel anschalte, dann leuchtet die ganze Umgebung drum rum, weil dieses durchsichtige Substrat das Licht weiterleitet. Deswegen musste dieses Wachstumssubstrat weg. Dazu wurde ein neuer Laser-basierter Prozess entwickelt. Der Prozess zum Entfernen des Wachstumssubstrats beansprucht aber die Verbindungsschicht zur Treiberschaltung erheblich. Das musste in der Prozessführung und beim Design der Verbindungsschicht berücksichtigt werden. Ein weiterer Punkt ist die Schichtdicke dieser Leuchtstoffschicht. Die Schichten, die man für normale LEDs verwendet, die sind viel zu dick, um ausreichenden Pixelkontrast zu bekommen. Wenn die Pixel nur noch 40 Mikrometer breit sind und ich bringe da 100 Mikrometer Leuchtstoffschicht obendrauf, dann habe ich wieder das Problem, dass bei einem eingeschalteten Pixel etwa zehn Pixel leuchten. Und deswegen war eine weitere Aufgabe, diese Leuchtstoffschicht so weit dünner zu machen, dass das perfekte Verhältnis von Pixel-Breite zu Schichtdicke entsteht. Dadurch leuchtet wirklich nur die Fläche der eingeschalteten Pixel, nicht die der ausgeschalteten Pixel daneben. Dazu musste sowohl ein neuer Leuchtstoff mit sehr viel kleineren Körnern entwickelt werden als auch ein Beschichtungsprozess, der solch dünne Leuchtstoffschichten gleichmäßig auf der LED-Oberfläche abscheidet.

All diese Schritte waren erforderlich und mussten funktionieren, damit das Ganze reif für die Anwendung in einem wie von uns gedachten Scheinwerfer möglich war.

Welchen Innovationsprozess haben Sie als Team durchlaufen von der ersten Idee bis zum Produkt?

Dr. rer. nat. Norwin von Malm

Angefangen haben wir um 2008 mit Konzepten und den Fragestellungen: „Wie realisiert man so eine LED des Digitalen Lichts?" Die LED und das Pixelieren haben wir uns selbst zugetraut. Aber: „Woher bekommen wir diese Treiberschaltung, die geeignet ist?" und „Wie verbindet man das miteinander, sodass jedes LED-Pixelchen auch thermischen, elektrischen und mechanischen Kontakt zu dem Träger-Wafer mit der Ansteuerschaltung hat?"

Da war uns sehr schnell klar, dass wir Partner an Bord holen müssen. Wir benötigten jemanden mit Silizium- und Elektronikkompetenz, das war damals Infineon. Wir suchten jemanden für die Verbindungstechnologie der beiden Halbleiter und wählten für diese Aufgabe das Fraunhofer IZM aus. Zudem suchten wir Partner, die das Ganze weiter in den Scheinwerfer und ins Auto integrieren. Da waren dann die Firmen Hella und Daimler mit beteiligt. Gemeinsam arbeiteten wir dann mit den Partnern im Förderprojekt „µ-AFS“ des Bundesministeriums für Bildung und Forschung. Unter der Leitung von Stefan Grötsch wurden dann in den Jahren 2013 bis 2016 intensiv Prototypen entwickelt.

Stefan Grötsch

Wir haben am Anfang einige Rückschläge hinnehmen müssen, was beispielsweise die notwendige Größe der LED-Chips angeht. Es gab Phasen, in denen wir wöchentlich miteinander sprachen, um zu klären, wo stehen wir, wann kommen welche Muster wohin? Das führte letzten Endes dazu, dass wir dann 2016 vor Ort bei Daimler ein Fahrzeug mit einem solchen Pixelscheinwerfer hatten. Wir konnten auf dem Werksgelände eine erste Probefahrt tätigen und haben die Technologie das erste Mal live in der Fahrzeuganwendung getestet. Ein voller Erfolg: Wir hatten erstmalig gezeigt, dass man pixelierte LED direkt auf einem Silizium-Treiber montieren und auch betreiben kann - im Scheinwerfer, im Auto. Mit diesem positiven Abschluss des Förderprojekts setzten wir den Startpunkt für die Industrialisierung der Technologie. Von da ab war dann aber noch viel Arbeit notwendig, um das wirklich in den Markt zu bringen.

Dr.-Ing. Hermann Oppermann

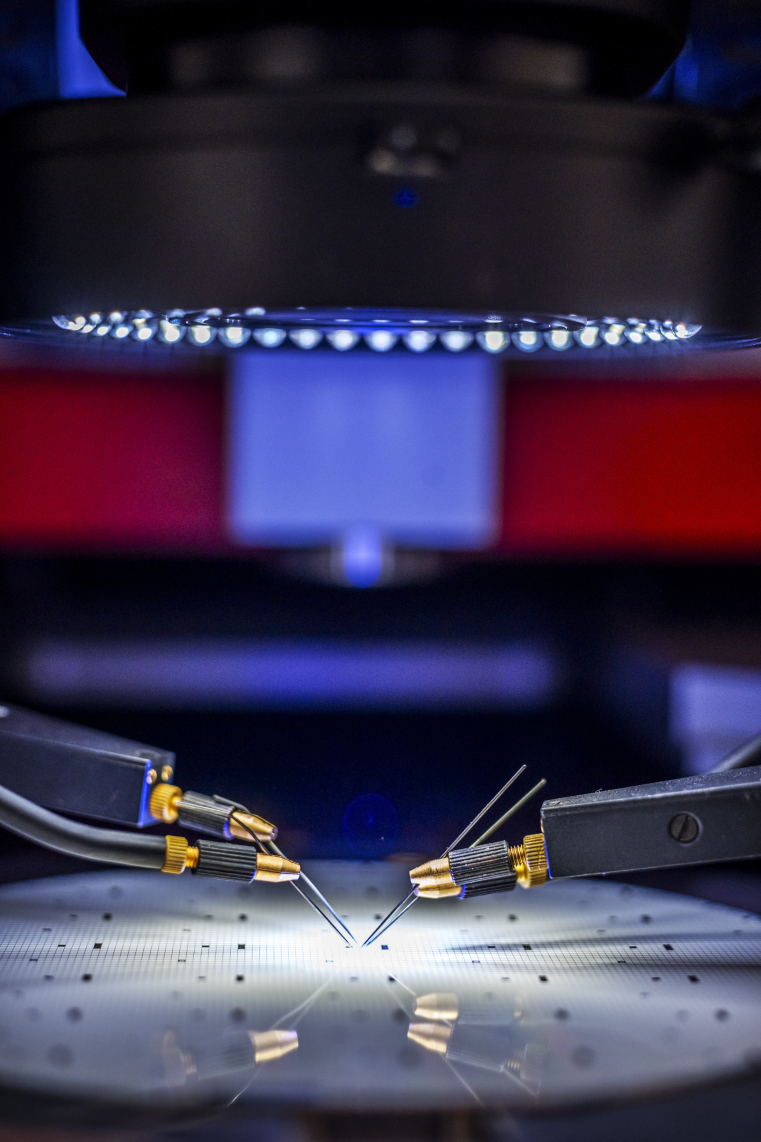

Als uns als Fraunhofer IZM damals das Konzept vorgestellt wurde, stellte sich schon heraus, was die größte Herausforderung ist: Zwei verschiedene Halbleiter miteinander zu verbinden, die unterschiedliche Ausdehnungskoeffizienten haben, also sich mit Temperaturänderungen unterschiedlich stark ausdehnen. Da wurde klar, dass das nicht so einfach wird wegen der thermomechanischen Belastung, dass es mit Standardlösungen, wie man sie sonst kennt, schwer wird. Jeder LED-Pixel, jeder Leuchtpunkt, musste mit einem individuellen Schaltkreis auf dem CMOS-Wafer elektrisch angeschlossen werden. Jeder LED-Chip besaß mehrere Hundert von solchen Pixeln, die alle mit dem CMOS-Treiber verbunden werden mussten.

Es mussten Lösungen für mehrere Herausforderungen gefunden werden: vor allen Dingen hinsichtlich der hohen Pixeldichte, hinsichtlich der Wärmeabfuhr und hinsichtlich des hohen Strombedarfs, der notwendig ist, um die Pixel zu betreiben. Neben dem elektrischen Kontakt für die Bestromung der LED-Pixel wurden weitere Kontaktflächen realisiert, die den LED-Chip thermisch besser an den CMOS-Chip anbinden, so dass beide Chips mechanisch eine robuste Einheit bilden.

Zu Projektbeginn war auch der LED-Baustein kleiner mit weniger Pixeln und wir hatten die Herausforderung, vier pixelierte Mikro-LEDs sehr nahe nebeneinander zu montieren, um größere Einheiten zu realisieren. Wir haben damals neue Konzepte entwickelt, um diesen Anforderungen gerecht zu werden: Wir sind mit einer neuartigen Verbindungstechnik an das Projekt gegangen. So haben sich beispielsweise die Anschlüsse selbst verkapselt. Zudem erreichten wir einen sehr hohen Wärmeleitwert, so dass die Wärme abgeführt werden kann. Wir haben mit einer festen Matrixschaltung begonnen, die es schon früh zu Projektbeginn gab, bevor die Treiberschaltung gefertigt werden konnte, damit wir die Montage der LED-Chips auf dem CMOS-Wafer entwickeln konnten. Das Ergebnis mit den neuen Konzepten sah von Beginn an wirklich gut aus.

Zunächst hatten wir begonnen, LED-Chips auf CMOS-Chips zu montieren und dabei die Verbindungen pixelfein zu erzeugen. Für Folgeprozesse war es dann aber erforderlich, die LED-Chips auf kompletten CMOS-Wafern zu montieren und dort die pixelfeinen Verbindungen zu erzeugen. Die Montage auf Wafer-Level war damit eine zusätzliche Herausforderung. Wir haben dann auch einen Aufstockungsantrag gestellt, um die Montage auf Wafer-Level zu ermöglichen und dabei mehr als 1.000 LED-Chips je Wafer zu verbinden. So konnten wir komplette Treiber-Wafer zur Verfügung stellen für die Nachfolgeschritte bei ams OSRAM.

Was war der zeitintensivste Anteil?

Stefan Grötsch

Ende 2016 hatten wir die Machbarkeit gezeigt - bis zum Fahrzeug. Daraus startete mit den damaligen BMBF-Partnern eine Industrialisierung für eine Lichtquelle mit 1.024 LED-Pixeln auf 4x4 mm². Diese Produktidee war sehr nahe am Ergebnis des Forschungsprojekts. Allerdings gab es einige anwendungstechnische Herausforderungen und die Aufwände zur Scheinwerferintegration hatten wir leicht unterschätzt. Diese waren im Forschungsprojekt noch akzeptabel, aber für die Serie nicht hinnehmbar.

Daher erfolge 2018 ein Neustart für das Produktkonzept. Soweit möglich versuchte ich in der Rolle des Systemarchitekten die Wünsche unserer Kunden zu konsolidieren: „Was ist die Lösung, die für euch relevant ist?" Außerdem hatte es zu dieser Zeit die Videoprojektionstechnik mit Mikrospiegeln als passive Lichtmodulatoren ins Auto geschafft. Damit konnten sehr viele Pixel nun auch Piktogramme auf die Straße projizieren, wenn auch mit geringer Effizienz.

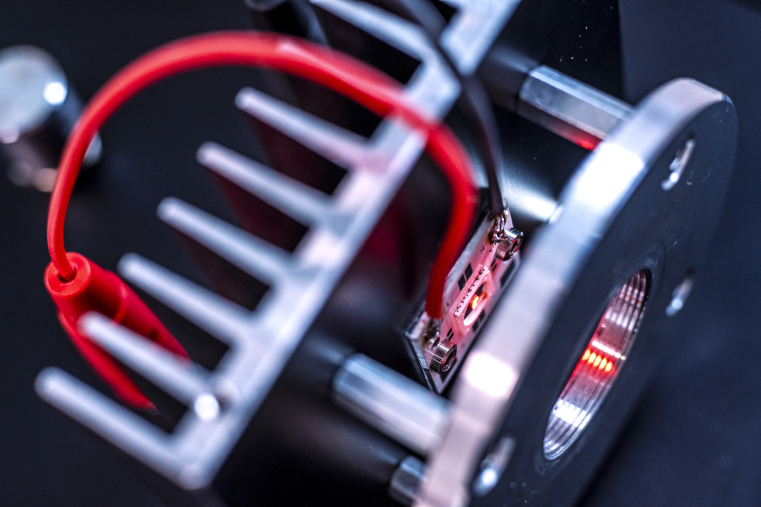

Um all das zu adressieren, haben wir jetzt ein Produkt industrialisiert, das mit ca. 41 mm² LED-Fläche 320 x 80 Pixel im Raster von 40 Mikrometern realisiert. Die Helligkeit reicht aus, um einen Scheinwerferbereich von ca. 24° x 6° aus einem Objektiv mit mehr als 80 000 cd auszuleuchten. Damit sind nun auch Piktogramme in Kombination mit hoher Effizienz möglich. Das ermöglicht kleinere Bauräume mit kostengünstiger Projektionsoptik und einfacherer Kühlung im Scheinwerfer.

Was wurde möglich, was bisher nicht möglich war? Was wäre vorher zu aufwendig oder zu groß gewesen?

Stefan Grötsch

De facto haben wir die Größe unseres LED-Arrays, getrieben durch den Wunsch, einen möglichst großen Winkelbereich des Scheinwerferkegels mit nur einer Optik auszuleuchten, signifikant von 4mm² über 16 mm² auf 41mm² vergrößert. Gleichzeitig mussten wir, um mehr Details darstellen zu können, das ansteuerbare LED-Element von 1mm² über 125 µm x 125 µm auf nun 40 µm x 40 µm verkleinern. In Summe können unsere Kunden damit nun Scheinwerfer bauen, die beispielweise per Software von Links- auf Rechtsverkehr entsprechend der UN-ECE Regulierungen oder auf den US-Standard umstellen. Um andere Verkehrsteilnehmer nicht zu blenden, können nun Pixel gesteuert werden, die selbst in 25 Metern vor dem Fahrzeug nur 3 bis 4 cm Kantenlänge haben. Es können nun Informationen für den Fahrer auf die Fahrbahn projiziert werden: Heute ist etwa schon das Schneeflockenpiktogramm gesetzlich erlaubt, welches vor Glatteis warnt. Auch die Warnung vor dem Auffahren oder die „Achtung! Geisterfahrer!“-Warnung ist möglich. Genauso kann man auf das Verlassen der Fahrspur hinweisen.

Als Sie dieses Projekt gemeinsam entwickelt haben und die verschiedenen Expertisen aufgeteilt: Wie haben Sie sich da organisiert, und welche Rollen haben Sie jeweils als Teammitglieder in der Entwicklungsphase gehabt?

Dr. rer. nat. Norwin von Malm

Die Erfahrung mit segmentierten LED-Chips, die ich ab 2008 gesammelt hatte, und dem Verständnis aus dem Kundengespräch, was für einen Scheinwerfer man sich wünscht, war der eigentliche Startpunkt. Das Konzept für eine pixelierte LED für diesen Scheinwerfer, wie könnte die auf so einer Treiberschaltung aussehen, was braucht man dafür, das habe ich am Anfang konzipiert. Aber dann ist sehr schnell klar geworden, das können wir alles nicht allein. Während der Vorentwicklungs-Phase habe ich dann die technischen Arbeiten am pixelierten LED-Chip geleitet.

Dr.-Ing. Hermann Oppermann

Wir als Fraunhofer IZM waren für die Verbindungstechnik und die galvanische Abscheidung auf den Wafern zuständig. Also dünne Gold-Pads auf den Wafern mit der Treiberschaltung, als auch Gold-Zinn auf denen mit den pixelierten LEDs. Wir haben also diese Verbindungsstrukturen additiv auf den Wafern aufgebracht. Und die gingen dann zurück zu ams OSRAM zum Vereinzeln in Chips. Diese Chips haben wir dann auf den Wafer mit der Treiberschaltung montiert.

Wir haben uns damals das Konzept angeschaut und dann zwei Vorschläge gemacht bezüglich der Verbindungstechnik. Wir haben diskutiert und uns nachher abgestimmt, dass wir die beiden Ansätze im Projekt erstmal parallel verfolgen. Der eine basierte auf Gold-Zinn-Lot. Der zweite arbeitete mit nanoporösem Gold. Mit diesen beiden Technologieansätzen sind wir reingegangen und beide waren erfolgreich. Mit dem Gold-Zinn-Lot konnten die pixelierten LED-Chips auf dem CMOS-Wafer gesetzt und die Verbindung durch Aufschmelzen des Lots hergestellt werden. Das ist ein schneller Prozess mit hohem Durchsatz und überschaubaren Fertigungskosten. Die LED-Chips mit nanoporösem Gold wurden unter Kraft und Temperatur auf den CMOS gepresst und verbunden. Die Lösung mit dem nanoporösen Gold lässt sich zu sehr kleinen Pixeln herunterskalieren. Wegen des schnellen Montageprozesses und wegen der bereits vorhandenen Expertise wurde dann der Beschluss gefasst, für den Wafer-Level-Prozess das Gold-Zinn-Lot weiterzuverfolgen.

Dr. rer. nat. Norwin von Malm

Es gibt die pixelierte LED auf der einen Seite und dieses Treiber-Array auf der anderen Seite. Die Frage ist, wie bringe ich das zusammen? Und das ist genau der Punkt, den Hermann hier eingebracht hat. Also die Verbindungstechnologie zwischen den zwei verschiedenen Welten, der Opto-Halbleiterwelt auf der einen Seite und der Silizium-Halbleiterwelt auf der anderen Seite.

Gibt es besondere Erfahrungen, die Sie aus Ihrer Zusammenarbeit als Inspiration mitgenommen haben?

Dr. rer. nat. Norwin von Malm

Die gab es ganz oft, daher sind externe Partner in solchen Projekten auch so wichtig. Das ist zwar immer ein bisschen aufwändiger, man muss alles abstimmen, Proben von A nach B schicken. Aber der Vorteil ist ganz klar, dass man Expertisen und Einsichten gewinnt, die man allein nicht hätte. Und ohne die Kooperation mit dem Fraunhofer-Institut wäre diese Markteinführung so nicht möglich gewesen.

Dr.-Ing. Hermann Oppermann

Für uns ist das auch immer neu, die Unternehmen bringen interessante Produktvisionen herein. Zudem definieren sie eine Funktionalität, die sichergestellt werden muss, und meistens auch die Bauelemente, so wie hier die LED-Seite und die Treiber-Seite, worauf wir dann gemeinsam die Lösungen erarbeiten. Das ist für uns immer interessant und da lernen wir auch etwas.

Stefan Grötsch

Vor dem Projekt entwickelte ich Hochleistungs-LEDs für Videoprojektoren, hatte Erfahrung mit großen Verlustleistungen und optischer Lichtprojektion. Durch den engen Austausch mit LED-Chip-Entwicklern konnte ich einiges über unsere Dünnfilm-LEDs lernen. Bei Projektstart war ich als Applikationsentwickler für Scheinwerfer direkt an der Kundenschnittstelle im Automobilbereich unterwegs. Da bot sich mir die Chance, in dieser Rolle das damalige Förderprojekt zu koordinieren. Dabei habe ich den Brückenschlag von den Herausforderungen der Halbleitertechnologie bis hin zu der Anwendung beim Fahrzeughersteller kennengelernt. Mit diesen Erfahrungen konnte ich nach Ende des Verbundprojekts als Systemarchitekt die Spezifikationen für die EVIYOS® LED in Abstimmung mit unseren Kunden definieren. In den sehr intensiven Jahren seit 2018 bin ich auch Zug um Zug in die Elektronik und Systementwicklung eingestiegen. In den letzten Jahren entwickelte ich mit meinem Team einen Teil der ASIC-Ansteuerung.

Wann haben Sie persönlich eine Leidenschaft für dieses Gebiet entdeckt?

Dr. rer. nat. Norwin von Malm

Ich hatte in der Schule eine Facharbeit über Kunststoffe geschrieben. Und damals hat mich begeistert, dass man die makroskopischen Eigenschaften von Materialien beeinflussen kann, wenn man die molekulare Struktur eines Materials versteht oder gezielt manipuliert. Das war für mich die Motivation, Chemie zu studieren. Nach bestandenem Vordiplom wurde mir klar, dass Materialwissenschaft dann doch was anderes ist. Die Chemiker freuen sich über einen kleinen gelben Kristall, den sie irgendwie nach 20 Stufen synthetisieren. Das allein hat mir aber nicht gereicht, ich wollte etwas Konkretes damit anfangen. Ich habe dann das Chemiestudium trotzdem beendet, mich aber relativ früh für die Diplomarbeit und dann später zur Promotion in die Materialwissenschaft begeben. Und mich in der Promotion insbesondere mit Materialien beschäftigt, die Licht erzeugen können, wenn man Spannung anlegt. Da ging es um Ladungstransport in organischen Halbleitern, also OLED-Technologie. Das hat mich so fasziniert, dass man Materialien in sinnvoller Weise zusammenbringt, Spannung anlegt, und dann kommt da Licht raus. Das war einfach toll. Und deswegen war für mich klar, ich möchte gerne im Lichtbereich weiterarbeiten. Durch Zufälle ergab es sich dann, dass ich eine Stelle bei (damals) OSRAM Opto-Semiconductors bekam. Zunächst als Prozessentwickler für thermische Prozesse. Das war ein relativ breites Spektrum an Tätigkeiten und Aufgaben. Und so hat sich das mit den Jahren weiterentwickelt. Aber die Faszination für das Licht und wie man das herstellt, die ist geblieben.

Dr.-Ing. Hermann Oppermann

Ja, bei mir war es fast ein ähnlicher Weg, also zumindest was die Werkstoffwissenschaften betrifft. Ich habe also Werkstoffwissenschaften und Werkstofftechnologie in Clausthal studiert, bin dann nach Berlin gewechselt und hab dort in der Metallphysik promoviert. Eigentlich eher Themen, die breit gefächert waren, die nichts mit dem zu tun hatten, was ich heute mache. Ich hatte dann die Möglichkeit, beim Forschungsschwerpunkt „Technologien der Mikroperipherik“ einzusteigen und dann zu Fraunhofer IZM zu wechseln, um dort die Verbindungstechnik, die ja auf Metallen beruht, weiterzubringen. Da habe ich mich dann schon früh mit Optoelektronik, mit Sensorik beschäftigt und einen guten Kontakt mit Kollegen bei uns gehabt und immer spezifische Lösungen gesucht für neue Anwendungen.

Stefan Grötsch

Ich habe mich eher durch Zufall für das Studium der Mikrosystemtechnik entschieden. Schon im Studium hatte ich nach einem kurzen Exkurs in die Siliziumspeicherfertigung die Chance gehabt, mich mit oberflächenemittierenden Laserdioden auseinanderzusetzen. Von da an hatten die Photonen mich gefangen und ich fand dann meinen Einstieg bei den infraroten Hochleistungslaserdioden des Siemens Halbleiterbereichs. Und nach einiger Zeit haben wir uns dann an farbige Laserdioden mit der Vision herangewagt, Videoprojektion zu machen. Dann kam die Idee auf, Projektion auch mit LEDs zu machen, ein Thema, das mich lange faszinierte. Kurz nach dem Forschungsprojekt kam ein erster LED-Projektor mit Mikrospiegelarray und 25 lm auf den Markt. Die letzten Prototypen vor meinem Wechsel in den Automobilbereich lieferten dann 2000 lm. Und dieses Thema Video war dann auch ein bisschen verwandt mit dem dynamisch ansteuerbaren Scheinwerferthema. Am Ende ist es ja quasi ein Schwarzweiß-Video, was wir jetzt auf die Straße werfen.

Gehen wir nochmal zu dem, was Sie jetzt schon entwickelt haben. Der Maßstab für den Erfolg des Projekts ist ja ein bisschen auch die Zufriedenheit der Nutzer. Was war das Feedback, als es in die Anwendung ging?

Stefan Grötsch

Im Scheinwerferbereich sehen wir, dass unsere aktive Lichttechnologie die passiven Pixel-Modulatoren, also das System, bei dem alles Licht immer an ist und dann entsprechend weggefiltert wird, verdrängen. Das liegt zum Beispiel an der besseren Effizienz, dem kleineren Bauraum oder dem nun größeren Fernfeldbereich unserer digitalen Lichttechnologie.

Unsere Kunden realisieren damit auch neue Anwendungsfälle im Scheinwerfer. Ein Beispiel ist der dynamische Lichtteppich auf der Autobahn. Gerade bei Gegenverkehr nehme ich nachts meine Fahrbahn weniger gut ausgeleuchtet wahr. Eine höhere Vorfeldhelligkeit von Spurmarkierung zu Spurmarkierung gibt da mehr Sicherheit. Auch kann ich dem Fahrzeug neben mir mitteilen, dass ich die Spur wechsle, wenn sich mein Lichtteppich dann ausdehnt. Die Technik erlaubt auch in Autobahnbaustellen und in Engstellen die Breite meines Fahrzeugs zu signalisieren. So dass ich sehr gut einschätzen kann: „Wie eng ist die Baustelle, komme ich gut durch?" Studien zeigten, dass diese Unsicherheit in Baustellen: „Kann ich überholen? Sollte ich lieber hinter dem Lkw bleiben?", so drastisch abnimmt. Und das führt dann auch zu weniger Stress in dieser Fahrsituation. Wirtschaftlich kann man sagen, wir haben mit dem Produkt viele am Markt auftretende Projekte gewonnen.

Wie sieht es denn mit der wissenschaftlichen Community aus? Gab es da Resonanz zu den Veröffentlichungen, die zum Projekt schon stattgefunden haben?

Dr.-Ing. Hermann Oppermann

Das hat natürlich eine gewisse Aufmerksamkeit erregt, dass man einen Scheinwerfer mit einer fein-pixelierten LED-Lichtquelle aufbauen kann. Wir konnten damals nach Projektende nicht sofort veröffentlichen. Aber wir haben dann eine abgestimmte Veröffentlichung gemacht, in der viele Konzepte noch nicht detailliert offengelegt worden sind. Aber die Erkenntnisse, die wir gewonnen haben, sind durchaus auch in andere Projekte eingeflossen. Auch in dem Sinne, dass man sich da dann auch für ähnliche Spezifikationen diese Technologie zutraut und weiterentwickelt.

Aber sieht man das Thema Digitales Licht als Zukunftstrend in der Forschung?

Dr.-Ing. Hermann Oppermann

Ja, wir sind viel unterwegs im Bereich der Photonik, insbesondere der Datenkommunikation in Datenzentren, High Performance Computing, neuronale Netze. Das sind klassische Themen in der Forschung heute. Die Herausforderungen hier sind ähnlich wie beispielsweise die hochdichte Anordnung von Lichtquellen und die Anbindung einer schnell schaltenden Elektronik. Da gibt es durchaus übertragbare Konzepte aus dem Projekt µAFS, die wir uns anschauen, so auch das Thema Wafer-Level Montage.

Dr. rer. nat. Norwin von Malm

Auch wir haben in der Weiterentwicklung der Miniaturisierung dieser Pixel immer mal wieder auch wissenschaftliche Publikationen gemacht. Und die sind angenommen worden und haben Anklang gefunden.

Wie sieht es mit weiteren Applikationen in der Zukunft aus, welche Schritte sind da noch zu machen?

Dr. rer. nat. Norwin von Malm

Jetzt haben wir bisher nur über die Scheinwerferanwendung gesprochen. Aber das Thema heißt „Digitales Licht“ und nicht „der neue Scheinwerfer“. Denn wenn man mal miniaturisierte LED-Pixel direkt auf einen Treiber setzen und ansteuern kann, dann kann man mit dieser Technologie sehr viel mehr machen als einen Autoscheinwerfer. Ein mögliches Anwendungsfeld wäre beispielsweise Augmented-Reality-Brillen (AR-Brillen). Die brauchen einen Bildprojektor, der in der Brille eingebaut ist und virtuelle Daten ins Auge spiegelt, die sich dann mit dem tatsächlichen, realen Bild überlagern. Da werden heute große Helme gebaut, in denen Projektoren drin sind. Aber das wollen sich ja viele gar nicht aufsetzen. Wenn das hingegen zukünftig in eine normale, tragbare Brille eingebaut werden soll, dann muss das ein sehr, sehr kleines Mikrodisplay sein. Und das muss sehr energieeffizient sein, denn niemand will einen großen Akkupack mit sich rumschleppen. Das muss mit wenig Strom, also effizient, funktionieren. Und das ist genau das, was man durch diese Miniaturisierung des Digitalen Lichts in Zukunft erreichen könnte. Man kann die Pixel sehr klein und sehr effizient machen. Und dadurch, dass sie direkt mit dem Treiber verbunden sind, ergibt das Ganze einen extrem kleinen, kompakten Projektor, der solche Applikationen wie AR-Brillen, überhaupt erst möglich macht.

Was ist denn aktuell die Schwierigkeit mit AR-Brillen? Sie sind sehr groß und schwer, wie so ein Helm auf dem Kopf. Und sie haben auch nicht so eine lange Leistung? Oder die Auflösung ist schlechter?

Dr. rer. nat. Norwin von Malm

Zur Auflösung gibt es verschiedene Möglichkeiten, wie man das technisch adressieren kann. Leider haben die alle irgendeinen bestimmten Nachteil: Es ist die Auflösung, die man hinbekommen muss, es ist die Energieeffizienz, die man schaffen muss. Und es ist die Langlebigkeit bei entsprechender Leuchtdichte. Denn wenn ich mit der Brille draußen im Sonnenschein unterwegs bin, dann will ich immer noch das virtuelle Bild sehen können. Das heißt, ich brauche eine hohe Leuchtdichte. Und wenn die Materialien diese Belastung einfach nicht aushalten, dann scheitert es daran.

Ist das mit der dünnen Leuchtstoffschicht eine Herausforderung, die auch für andere Anwendungen besteht? Oder ist das etwas Spezifisches für den Scheinwerfer?

Dr. rer. nat. Norwin von Malm

Diese Leuchtstoffschicht war spezifisch für die Scheinwerfer, denn wenn man dort eine digital vorgegebene Lichtverteilung haben will, muss man auch dafür sorgen, dass nur dort Licht rauskommt, wo man es haben will. Für Beleuchtungsanwendungen allgemeiner Art spielt das erstmal keine Rolle. Will man aber beispielsweise ein steuerbares Innenraumlicht für ein Auto, wäre das auch wieder relevant. Also immer da, wo man weiße Lichtverteilungen steuern will, braucht man diese dünne Leuchtstoffschicht.

Für das Thema Augmented Reality fällt das mit der Konversion weg. Denn da braucht man Rot und Grün und Blau als reine Farben. So funktionieren die meisten Displays, die können nur Rot, Grün und Blau darstellen, alle anderen Farben werden dann daraus gemischt. Aber daraus ergeben sich andere Herausforderungen, weil man eben nicht nur blaue Pixel herstellen muss, wie wir sie jetzt in dem Scheinwerfer haben, sondern man braucht auch die anderen Farben. Und gerade bei Rot muss man das Halbleitermaterialsystem wechseln. Das ist dann nicht mehr Galliumnitrid-basiert, sondern aus Indium-Gallium-Aluminiumphosphid. Und da gibt es zusätzliche Herausforderungen, die man lösen muss, insbesondere für die Effizienz der Pixel, wenn sie immer kleiner werden.

Wenn wir jetzt den Horizont aufmachen für mögliche Anwendungen: Was sind die Möglichkeiten, die sich mit AR auftun?

Dr. rer. nat. Norwin von Malm

Anwendungen für AR-Brillen können sehr vielseitig sein. Im professionellen Bereich kann man sich vorstellen, dass ein Wartungsingenieur zu einer Anlage kommt und durch die Brille gezeigt bekommt, was er machen muss: „Hier, diese Schraube musst du drehen oder hier musst du etwas verstellen." Oder der Operateur im Krankenhaus könnte in seinem Sichtfeld überlagerte Informationen angezeigt bekommen, die aus Röntgen-, Ultraschall- oder MRT-Bildern stammen und die Stelle markieren, an der er schneiden sollte. Einen militärischen Anwendungsbereich gibt es sicherlich auch. Große Verbreitung können AR-Brillen aber im Consumer-Bereich finden: Die Idee ist, dass wir irgendwann nicht mehr unser Handy mit uns rumschleppen und auf den schwarzen Kasten schauen. Alle Informationen, die man heute am Smartphone abrufen würde, die hätte man dann direkt in die Brille eingespielt. Das würde das Interface zwischen Mensch und IT drastisch verändern. Das wird aus meiner Sicht einen großen Effekt auf die Gesellschaft haben.

Dr.-Ing. Hermann Oppermann

Heute gibt es Lösungen mit OLEDs. Aber denen fehlt die Brillanz, also die Helligkeit und der Kontrast, wenn man unter normaler Beleuchtung oder im Außenbereich etwas darstellen will. Da braucht man dann sehr kleine LEDs. Und da muss man von der Größe her hin, wo die OLEDs heute sind oder sogar noch besser. Genau dafür eignen sich die LEDs des Digitalen Lichts mit ihrer Vielzahl an einzeln ansteuerbaren Pixeln und haben daher das Potenzial, auf dem Feld der Augmented Reality Projektoren in Brillen und als Head-up Display im Auto erfolgreich zu sein.

Dr. rer. nat. Norwin von Malm

Über Auto und AR hinaus eröffnet die Technologie auch eine ganz breite Palette von anderen Anwendungen. Auch solche, die wir uns heute vielleicht noch gar nicht vorstellen mögen. Ein weiteres Beispiel, das schon möglich wäre, sind transparente Displays. So erscheint etwa in einer Fensterscheibe auf Knopfdruck ein Display. Das kann man machen, indem man diese Pixelchen, die sehr klein sind, voneinander beabstandet auf das Fensterglas setzt, mit entsprechender Treiberschaltung dahinter. Das Ganze ist dann durchsichtig. Auch weil der Anteil der Fläche, der durch die LED-Pixel belegt ist, sehr klein ist. Es ist einfach viel Fläche dazwischen. In dieser freien Fläche dazwischen ließe sich aber auch Mikrosensorik einbauen. Ich könnte also kleine lichtempfindliche Fotodioden zwischen die LED-Pixel setzen und hätte dadurch eine Art verteilte 3D-Kamera, die dann Gestenerkennung machen kann oder Gesichtserkennung, Verifikation, solche Dinge.

Wir haben bisher immer nur von Anwendungen im Bereich Projektion oder auch Display gesprochen, bei denen Informationen eingespiegelt oder angezeigt werden.

Licht ist aber auch ein Informationsträger, allerdings auch auf ganz anderen Ebenen. Im Computer zum Beispiel, um künstliche Intelligenz noch weiter voranzutreiben. Man kann die Technologie des Digitalen Lichts nämlich auch für die Datenkommunikation zwischen Servern oder zwischen verschiedenen Computer-Chips verwenden. Heute wird das Thema künstliche Intelligenz auch dadurch begrenzt, dass ein Prozessor nicht mit genügend Speicher gleichzeitig kommunizieren kann. Das liegt einfach daran, dass man dort Kupferverbindungen braucht, die den Prozessor mit dem Speicher verbinden. Das bedeutet, der Speicher muss direkt neben dem Prozessor sitzen. Damit ist der Platz um den Prozessor irgendwann voll. Und mehr Speicher gibt es dann nicht. Jetzt kann man diese kleinen LED-Pixel aber dazu benutzen, als Array, also als Matrix von X mal Y Chips, in ein Faserbündel einzukoppeln. Und so eine Art leuchtenden zwei 2-D QR-Code erzeugen. Diesen QR-Code, den transferiert man parallel, also gleichzeitig, durch das Faserbündel auf eine Detektor-Seite, die aus der gleichen Anzahl von lichtempfindlichen Detektoren besteht. So kann man diese QR-Codes, also nichts anderes als digitale Daten, einen nach dem anderen über das optische Kabel übertragen. Damit kann der Speicher weiter entfernt von dem Hauptprozessor platziert werden. Ich kann also optisch mehr Speicher an diesen Prozessor anbinden. Und das ist auch thermisch besser. Das wird ein wesentlicher Baustein sein, um die KI-Anwendungen zum Laufen zu bringen.

Welche KI-Anwendung wären hier möglich?

Dr. rer. nat. Norwin von Malm

Alle Anwendungen, die man sich heute in Clouds überlegt, die brauchen diese Art von optischer Datenübertragungs-Technologie. Denn elektrisch ist man dort einfach limitiert. Und wenn man noch weiter in die Zukunft denkt, dann könnte man sich vorstellen, dass man nicht nur Informationen transferiert von A nach B, sondern dass man auch optisch rechnet. Also eine Art optischer Computer-Prozessor. Da würde dann eine Matrix aus LED-Pixeln mit einer Matrix aus Fotodioden wechselwirken. Diese Wechselwirkung repräsentiert, dass ein Neuron mit mehreren anderen Neuronen verknüpft ist. Durch die Vielzahl der Pixel kann man so komplexe neuronale Netzwerke künstlich herstellen. Und das könnte in Zukunft der neue Computer sein.

Wenn man von Stromeinsparungen spricht, haben Sie gesagt, man muss jetzt nicht mehr alles anschalten, sondern nur noch das, was man ansteuern will. Kommt die Stromeinsparung eher daher, dass man das nicht mehr auf einer Platine verbauen muss, oder durch diese elektrischen Kontakte, die dann nur noch einzeln angeschaltet werden?

Stefan Grötsch

Die Energieeffizienz ergibt sich dadurch, dass man nur noch die LEDs für die Zeiten einschalten muss, die für das Bild auch wirklich notwendig sind. Und das ist ein wesentlicher Unterschied zu anderen Technologien, die die ganze Beleuchtung aktivieren und dann das Licht wieder teilweise vernichten müssen. Im konkreten Beispiel für den Scheinwerfer ist die Konkurrenztechnologie mit permanent 60 bis 70 Watt unterwegs, um eine kleinere Lichtausbeute zu erzeugen. Unser Modul hat eine Leistungsaufnahme von im Mittel 19 und in der Spitze bis 40 Watt und hat dann aber bei den 40 Watt das doppelte Licht. Das ergibt sich aus der aktiven Ansteuerung der Pixel.

Auch die Datenraten sind eine Herausforderung, die wir bewältigen mussten. Schon bei den 25.600 Pixeln haben wir auf der untersten Ebene Datenströme mit drei bis zwölf Gigabit pro Sekunde zu bedienen. Und im Auto sehen wir eigentlich Datenleitungen, die nur ein Megabit bringen. Das ließ uns Lösungen suchen, wie man Videotechnik in den Scheinwerfer bringt. Das sind Aspekte, die wir jetzt in der Elektronikentwicklung aufgegriffen haben, die die Grundsteine dafür legen, die Anwendung weg vom Scheinwerfer hin zu den Videoanwendungen für AR oder ähnliche Themen zu ermöglichen.

Dr. rer. nat. Norwin von Malm

Diese Energieeffizienz ist natürlich immer dann besonders wichtig, wenn man nur wenig Energie mitnehmen kann. Gerade bei AR-Brillen ist das der Fall – der Akku in der Brille muss ja eine Weile halten. Wenn man dort Ansätze verfolgt, wo man das ganze Bild beleuchtet und dann selektiv Licht wegfiltert, um ein Bild zu kreieren, dann ist das nicht effizient und einfach keine nachhaltige Lösung.

Und im Bereich Datenkommunikation: Wenn man das optisch löst statt elektrisch, könnte man mit nur einem Viertel der Energie arbeiten. Und man weiß, dass diese Data Centers, die das Internet bereitstellen, heute einen immensen energetischen Aufwand zur Kühlung betreiben müssen, aber auch, um die Daten hin und her zu schaufeln. Und das würde mit deutlich weniger Energie funktionieren, wenn wir hier LED-Pixel-Arrays nutzen, deren Signale wir optisch transferieren statt elektrisch.

Wie wird das Digitale Licht unsere Welt verändern?

Dr. rer. nat. Norwin von Malm

Ich glaube, das geht in Wellen. Das große Potenzial heute ist der Autoscheinwerfer und das Autorücklicht. Auch im Rücklicht kommen in Zukunft segmentierte Designs in den Markt und dafür braucht man einzeln ansteuerbare rot leuchtende LED-Pixel. Die nächste Welle wird das Thema Augmented Reality sein. Und das wird auch der Teil sein, der vielleicht den Leuten die Änderung durch die Technologie des Digitalen Lichts bewusster macht als im Auto. Ins Auto setze ich mich rein und fahre, und das Digitale Licht leuchtet mir den Weg. Menschen, die sich für das Thema interessieren, sehen dann die variablen Lichtverteilungen, aber vielleicht nicht jeder. Beim Thema Augmented Reality ist das für jedermann sichtbar, dass ich eben kein Handy dabeihaben muss, sondern dass ich alle wichtigen Informationen über meine Brille in die Augen gespiegelt bekomme. Und solche Themen wie künstliche Intelligenz oder neuromorphe Netze ist etwas, das unsere Gesellschaft in der Zukunft, wenn es denn so kommt, nachhaltig verändern wird.

Welche Schritte sind noch notwendig, um solche neuartigen Produkte außerhalb der Automobilindustrie, die Sie jetzt schon bedienen, zur Marktreife zu bringen?

Dr. rer. nat. Norwin von Malm

Effizienz ist dort noch immer ein Problem. Die Standard-LED ist nahe an ihrem Effizienzmaximum angekommen. Da ist sicher noch hier und dort ein Prozentchen an Effizienzsteigerung drin. Aber viel ist da nicht mehr zu erwarten, weil man einfach schon relativ nahe an der 100-Prozent-Marke ist, und mehr wird es nicht. Wenn man diese Pixel immer kleiner macht, dann fällt die Effizienz aber sehr drastisch ab. Bei kleinsten Pixeln reden wir da eher von Effizienzen von einem Prozent oder zwei oder so. Das liegt daran, das bei immer kleineren LED-Pixeln der „Rand“ der leuchtenden Schicht im Verhältnis zu deren Fläche immer weiter zunimmt. Und dieser Rand verbraucht den Strom wegen Defekten im Halbleiterkristall leider eher ohne dabei Licht auszusenden. Bei großen LEDs mit Flächen im Bereich von Millimetern ist das kaum ein Problem, wenn die Pixel aber nur noch einige wenige Mikrometer groß sind, bestehen sie ja praktisch nur noch aus Rand. Da ist also bezüglich Effizienz noch viel Luft nach oben. Das wird man auch tun müssen, um diese Applikationen sinnvoll bedienen zu können - und daran arbeiten wir unter anderem gerade.

Auf den großen gesellschaftlichen Aspekt geblickt: Was glauben Sie, welche Auswirkungen Ihre Innovation auf den Industriebereich haben wird?

Dr. rer. nat. Norwin von Malm

Ich glaube, dass man mehrere ganz unterschiedliche Anwendungen sehen wird, die man vielleicht nicht sofort mit der Technologie des Digitalen Lichts in Verbindung bringt, die aber doch unser Leben deutlich verändern. Das wird uns indirekt treffen, ohne dass jemand sieht, das ist jetzt Digitales Licht.

Stefan Grötsch

Im Auto sind es vorrangig die Aspekte Sicherheit, Komfort und Effizienz. Sicherheit hat eine hohe Relevanz, weil man durch die Technologie Unfälle vermeiden kann. Statistiken zeigen, dass die Nachtfahrsituation eigentlich im Verhältnis zu den Stunden oder den Kilometern, die man zurücklegt, besonders unfallträchtig ist. Da ist bessere Lichttechnik immer ein Hebel, um das zu verbessern. Und das Thema Augmented Reality wird, wenn das ausgerollt wird, ähnlich relevant sein wie die Einführung von Smartphones und Tablets in unser Leben. Das sind Consumer-Wellen, die auf die Gesellschaft zugerollt sind, und das wird hier ähnlich sein.

Dr.-Ing. Hermann Oppermann

Ich kann das nur bestätigen. Also ich denke auch: Augmented Reality wird einiges verändern sowohl auf dem Produktlevel, aber auch wahrscheinlich dem Erlebnislevel, wie die Leute dann damit umgehen werden. Im Bereich Datenkommunikation wird das wahrscheinlich für viele nicht sichtbar sein. Aber was da heute an Energie verbraucht wird, das muss reduziert werden. Wir brauchen energieeffizientere Datenkommunikation, also energieeffizientere Prozesse. Und das werden wir erleben, auch wenn wir es nicht sehen.

Was sind die nächsten Schritte? Woran arbeiten Sie jetzt, um das Thema weiterzutreiben?

Dr. rer. nat. Norwin von Malm

Die Miniaturisierung, also die Pixel kleiner zu machen, mehr Pixel auf der Fläche unterzubringen. Das Thema RGB, also Rot-Grün-Blau statt nur Weiß, und die integrierte Sensorik, daran wird man weiterarbeiten wollen. Dass man also auf transparenten Displays auch Sensorik unterbringt, so dass man eine transparente Scheibe hat, die nicht nur Informationen beliebiger Art darstellen kann, sondern auch meine Reaktion darauf erkennt.

Dr.-Ing. Hermann Oppermann

Wir haben damals in dem Projekt mit Pixel-Arrays gearbeitet, die montiert werden mussten. Wenn man zu RGB geht, dann wird man von den Arrays wahrscheinlich weggehen, dann müsste man jeden einzelnen Pixel transferieren. Das heißt, wir reden über Technologien, bei denen man multiple LEDs mit einem Schritt assembliert. Da gibt es unterschiedliche Forschungsrichtungen in dieser Hinsicht. Und dann kommt es auch darauf an, neben dem Transfer auch die elektrische Kontaktierung sicher zu stellen. Das sind zwei wesentliche Herausforderungen, woran heute auch bei uns intensiv gearbeitet wird.

Stefan Grötsch

Konkret im Scheinwerferbereich sehe ich heute neben dem Trend, den Norwin schon genannt hatte - kleinere Pixel, mehr Pixel, größere Flächen - die Notwendigkeit, sich mit dem Thema der Datenkommunikation im Auto auseinanderzusetzen. Wie wird das gehandelt? Wie kommen diese Mehrdaten, die pro Pixel notwendig sind, in dieses Teilsystem zu diesem Chip? Und das ist durchaus ein Thema, mit dem ich mich heute mit meinem Team auseinandersetze. Es gibt in der Industrie einen Wandel der Elektronikarchitekturen. Und dem müssen wir Rechnung tragen, um uns dementsprechend vorzubereiten.

Was machen Sie in Ihrer Freizeit, wenn Sie nicht an den Arbeitsthemen sitzen?

Dr. rer. nat. Norwin von Malm

Ich habe eine Holzwerkstatt im Keller, um mal etwas mit den Händen zu schaffen, dass man danach anfassen und anschauen und vielleicht sogar benutzen kann. Etwa Möbelstücke oder Kinderspielzeug. Das mache ich ganz gern, weil das inzwischen ein bisschen verloren gegangen ist in meiner derzeitigen beruflichen Position.

Dr.-Ing. Hermann Oppermann

Bei mir ist es vor allem Musik hören, Kochen, Zeit mit der Familie verbringen, lesen.

Stefan Grötsch

Neben der Familie habe ich ein Faible für das Mountainbike-Fahren, da gibt es um Regensburg schöne Hügel, wo man gut entspannen und sich auch mal einen Adrenalinkick holen kann, wenn man am Steinbruch entlang den Kamm runterfährt. Aber ich habe auch eine kleine Bastelwerkstatt, und da steht ein Lasercutter, mit dem ich ab und an etwas ausprobiere. Das macht man dann eine Zeit lang und dann widmet man sich wieder den richtig coolen Themen in der Arbeit.

Vielen Dank für das Interview!

Gebärdensprache

Gebärdensprache

Leichte Sprache

Leichte Sprache