Also haben wir uns gefragt, wie kann man dem Computer das beibringen und erkennen, ob dort auch wirklich Fortschritt ist. Und das war der Punkt für uns, dass wir den Prozess umgedreht haben. Und das bezeichnet man als Generative KI. Also Computer, die nicht in Bildern direkt etwas erkennen, sondern Computer, die in der Lage sind, das, was sie glauben über eine Klasse von Objekten zu wissen, wieder zu synthetisieren. Ich sage also dem Computer, wenn du jetzt Hunde von Katzen unterscheiden kannst, Krebsgewebe zum Beispiel von gesundem Gewebe, dann zeig mir doch, wie für dich ein Krebs aussieht, zeig mir doch, wie für dich ein Hund aussieht. Und wenn in dem Fall nur Hundeknochen rauskommen, aber keine Hunde, dann weiß ich natürlich, dass er danebengelegen hat. Das war für uns ein Aufhängepunkt, uns mit Generativer KI zu beschäftigen, weil unser Grundziel natürlich weiterhin ist, dem Computer das Sehen beizubringen, das ist Computer Vision als eine der vielen Fähigkeiten von künstlicher Intelligenz.

Das klingt nicht ganz einfach. Was muss ein Computer können, um das lernen zu können?

Prof. Dr. Björn Ommer

Generative KI im Allgemeinen und das Generieren von Bildern im Speziellen sind äußerst aufwendige Prozesse, die viel Rechenleistung erfordern. Die Entwicklung ging in eine Richtung, in der in kurzer Zeit nur noch wenige große Firmen diesen Bereich dominieren würden, weil nur sie über die nötige Rechenpower verfügen – nicht nur für das Training und die Entwicklung der KI, sondern auch für ihren Betrieb in der Anwendung. Diese Firmen besitzen große Rechenzentren, die leicht Milliarden Dollar kosten können. Wären sie die Einzigen, die diese Technologie aus kommerziellen Interessen nicht nur als geschlossene, proprietäre Software weiterentwickeln, sondern auch betreiben könnten, hätten wir ein Problem: Uns war relativ schnell klar, dass diese Technologie eine Basistechnologie wird, die nahezu alles, was wir in unserer Gesellschaft und unserer Wirtschaft machen, in Zukunft durchziehen wird.

Wir sprechen heutzutage von Foundation Models, weil es eine Technologie ist, die nicht um ihrer selbst willen entwickelt wird, sondern weil es eine Technologie ist, die effektiv eine Foundation wird, also eine Grundlage für andere Technologien, die da drauf aufbauen, so wie der Personal Computer oder die Elektrizität. Wir haben nicht elektrischen Strom wegen des elektrischen Stroms gemacht, sondern weil man damit unendlich viele andere Dinge durchführen kann. Generative KI wird also zu einer Enabling Technology, einer Ermöglichungstechnologie für zukünftigen technischen Fortschritt, der sich breit durch die Gesellschaft zieht. Gleichzeitig wäre diese Technologie wegen ihres Rechenbedarfs auf einige wenige große Firmen beschränkt, die insbesondere auch noch im Ausland sitzen. Dies bedeutet eine potenziell kritische technologische Abhängigkeit. Also haben wir uns gefragt, wie können wir dafür sorgen, dass die Allgemeinheit an diesem Fortschritt partizipieren kann? Wie können gewöhnliche User, kleinere Labs und Start-ups, die diese Technologie in Zukunft brauchen, einen möglichst direkten Zugang zu dieser Technologie bekommen? Nicht nur indirekt durch ein paar wenige große Firmen, von denen sie dann abhängig sind und denen sie ihre Daten anvertrauen müssen. Diese könnten den Zugang später auch nach eigener Entscheidung beschränken. Ein wesentliches Ziel von Stable Diffusion war dementsprechend die Demokratisierung Generativer KI. Einen allgemeinen, gleichberechtigten und souveränen Zugang zu dieser zukünftig kritischen Grundlagentechnologie zu ermöglichen, indem wir Generative KI auf gewöhnlicher, erschwinglicher Consumer Hardware lauffähig machen, die wenige hundert statt hunderte Millionen Euros kostet.

Wie funktioniert Stable Diffusion?

Prof. Dr. Björn Ommer

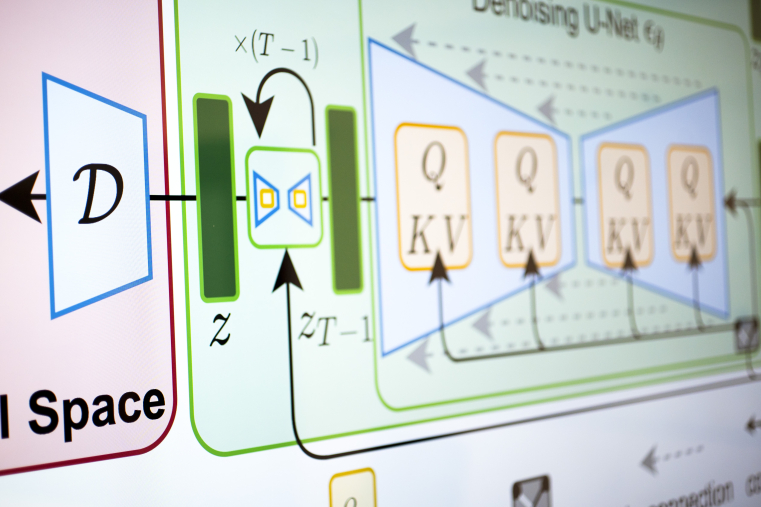

Hier müssen wir zwei Phasen unterscheiden: Das Training, bei dem die KI lernt, Bilder zu verstehen, und die Anwendung der KI, um z. B. Bilder zu erzeugen. User sehen primär das Zweite, also die Anwendung der bereits trainierten KI. Sie beschreiben eine Szene mit Text und die KI erzeugt dann aus diesen wenigen Wörtern ein Bild mit Millionen Pixeln. Alternativ kann man auch ein Bild eingeben und dieses dann vervollständigen, also Verdeckungen auffüllen oder entsprechend einer Textbeschreibung verändern. Da Computer zuerst einmal dumm sind und das nicht können, stellt sich eine grundlegende Frage: Wie bringe ich einem Computer bei, Bilder zu verstehen, um dann Text in Bilder zu verwandeln? Diesem Training liegt bei Stable Diffusion ein sogenanntes Diffusionsmodell zugrunde. Das bedeutet, dass ich mit einem Trainingsbild anfange und auf dieses Bild Rauschen addiere. Ein kleines bisschen Rauschen, sodass wir als Menschen gar nicht den Unterschied wahrnehmen würden. Aber diese Diffusion, dieses Addieren des Rauschens wiederhole ich hunderte oder tausend Male. Wenn ich diese kleinen Schritte so häufig wiederhole, dann sieht das Endergebnis so aus, als ob ich aus meinem Fernseher das Antennenkabel gezogen hätte. Nur Schnee, nichts zu erkennen. Warum mache ich Bilder effektiv kaputt? Warum nehme ich das Signal raus? Das mache ich, um diesen Prozess umzudrehen. Denn dann habe ich das Bild, das verrauscht ist und das Bild, was ein bisschen weniger verrauscht ist. Und wenn ich diese beiden Bilder einer KI, in dem Fall einem neuronalen Netz, zeige, kann sich jeder vorstellen, dass das doch gehen müsste, so ein ganz kleines bisschen Rauschen wegzunehmen.

Nun kann ich diesen umgekehrten Prozess, das Rauschen in kleinen Schritten zu eliminieren, hundert- oder tausendmal wiederholen. Das bedeutet, dass ich mit purem Rauschen starte und irgendwann zwar nicht genau das Bild herausbekomme, mit dem ich gestartet habe, aber etwas, was qualitativ ähnlich ist. Der Computer fängt auf diese Weise an zu verstehen, was die Essenz des Bildes ausmacht. Was ich dabei bekomme, ist effektiv eine hierarchische Repräsentation von Bildern entsprechend des Rauschniveaus. Zuerst lernt die KI das Große und Ganze, Kontext, der quer über das Bild reicht. Beispielsweise, woher das Licht kommt, Schattenwürfe und Reflexionen und, ganz grundlegend, ob es sommerlich hell oder düster ist. Wir wollen ja nicht unkontrolliert einen Sommertag in einem Teil des Bildes und einen Winterabend in einem anderen Teil haben. Später in dieser Hierarchie lernt die KI dann lokalere Details, wie z. B. Teile eines Gesichts. So lernt die KI eine semantische Hierarchie, eine Zerlegung des Bildes in unterschiedliche semantische Details. Das alles zusammengenommen gibt mir dann ein Modell, bei dem ich in der späteren Anwendung mit einer Textbeschreibung und purem Rauschen starte. Die KI fügt dann schrittweise Details hinzu, bis ich beim fertigen Bild ankomme. Besonders an Stable Diffusion ist, dass dies nicht direkt im Raum der Bildpunkte geschieht. Bei Millionen Pixeln würde die KI den Wald vor lauter Bäumen nicht erkennen – vor lauter lokalen Details würde sie die globalen Zusammenhänge in einem Bild vergessen. Deshalb lernt Stable Diffusion während des Trainings zuerst eine Repräsentationssprache für die lokalen Details. Basierend auf dieser Repräsentation kann sich die KI dann auf den Kontext im Bild konzentrieren, ohne durch die lokalen Details überfordert zu werden. Durch dieses zweigeteilte Modell haben wir eine KI geschaffen, die hochaufgelöste Szenen lernen kann, aber gleichzeitig sehr wenig Speicher benötigt und entsprechend auf erschwinglicher Hardware läuft.

Diffusionsmodelle hat es vorher gegeben, aber die waren effektiv zu groß. Erst durch diesen zweischrittigen Prozess sind sie effizienter geworden. Stable Diffusion ist zuerst einmal in der Allgemeinheit bekanntgeworden als ein Text-zu-Bild-Generator. Ein System, bei dem ich mich als Mensch hinsetzen kann und Text eintippe, eine Beschreibung einer Szene z. B., und dann kommen hinten Bilder heraus. Es geht aber deutlich darüber hinaus. Wir haben hier mit Generativer KI zum ersten Mal eine Technologie, die gleichzeitig leistungsfähiger ist und einfacher zu nutzen. Bisher war es so, dass Technologie, die leistungsfähiger war, immer komplizierter geworden ist. Als Informatiker kann man dem Computer schon sehr vieles beibringen. Aber man muss programmieren können. Generative KI, und jetzt gehen wir wieder ein bisschen über Stable Diffusion hinaus, zeichnet sich dadurch aus, dass ich dem Computer in natürlicher Sprache sagen kann, worum es mir eigentlich geht, und er das immer besser versteht und umsetzen kann und mir das geben kann, was mich eigentlich interessiert.

Auf diese Art und Weise wird effektiv Deutsch, Englisch, was auch immer, zu einer neuen mächtigen Programmiersprache, die sie vorher nicht gewesen sind. Warum jetzt so schnell? Weil Generative KI effektiv zum Nachbrenner geworden ist für Dinge, die man sowieso schon am Computer machen wollte oder bereits gemacht hat, nur deutlich schneller und einfacher als früher. Ich muss keine Programmiersprache oder Ähnliches lernen, ich kann das in natürlicher Sprache machen und das, was ich vorher gemacht habe, einfacher, besser und qualitativ hochwertiger durchführen. Daher ist das so explodiert, so schnell in die Allgemeinheit der Bevölkerung hereingekommen. Der Computer versteht mich in natürlicher Sprache. Stable Diffusion demokratisiert diese KI nun und macht sie für eine breite Öffentlichkeit auf gewöhnlicher Hardware zugänglich.

Bleiben wir bei dem Text-zu-Bild-Generator. Wenn ich die Generative Bild-KI nutze, warum sind die Ergebnisse immer unterschiedlich, obwohl ich denselben Prompt eingebe?

Prof. Dr. Björn Ommer

Unsere visuelle Welt ist unendlich kompliziert. Diese unendliche Komplexität zu erfassen, ist unendlich diffizil. Was wir also machen, ist, eine Bildbeschreibung in Text einzutippen. Wie viele Bilder passen auf den Text-Prompt? 100.000, 1 Million, 10 Millionen, Milliarden? Der Raum der Möglichkeiten, den man dort hat, ist eine Zahl, die können wir uns nicht vorstellen. Wir haben ein Modell genommen, bei dem wir diese Unsicherheit, die Unschärfe oder diese Breite versuchen, in zwei Teile aufzuteilen. Der eine Teil ist deterministisch, der ist vorbestimmt, gewissermaßen durch den Text-Prompt, den man als Nutzer dort eingibt. Um den Rest aber und diese unendlich vielen Möglichkeiten abzufangen, haben wir davor, bildlich gesprochen, einen Würfel gesetzt. Das heißt, das System würfelt einmal, wählt dann eine Möglichkeit aus, die zu dieser Textbeschreibung passt, und kann auf diese Art und Weise, wenn man jetzt diesen Prozess sehr häufig wiederholt, mit genau derselben textuellen Beschreibung, eins nach dem anderen alle möglichen Bilder generieren, die zu dieser Textbeschreibung passen. Ich finde es eher spannend, wie sehr wir Menschen davon ausgehen, die Idee in meinem Kopf, das muss da rauskommen." Wir sehen, wie wenig menschliche Sprache vorherbestimmt, was wir eigentlich meinen. Was natürlich erklärt, warum wir Menschen immer so über Kreuz liegen. Weil das, was ich in meinem Kopf habe und symbolisch durch Sprache ausdrücke, natürlich mitnichten der Realität entspricht, sondern nur eine sehr abstrakte Beschreibung ist. Wir haben hier den Raum der Möglichkeiten auf eine einzige Zahl reduziert. Wenn man diese Zahl fix hält und derselbe Text-Prompt wieder eingegeben wird, kommt genau dasselbe Bild heraus. Jeder einzelne Pixel ist identisch. Wenn ich statt dieser Zahl eine andere Zahl eintippe, kommt ein anderes Bild, das zu diesem Text-Prompt passt. Und auf diese Art und Weise hat man etwas, was deterministisch ist, was also vorbestimmt ist durch den Prompt und das KI-Modell.

Das große Ziel ist ja die Demokratisierung der KI. Das bedingt, dass das Modell, also das Stable Diffusion Modell, auf wesentlich kleineren Rechnern läuft als die anderen Modelle, die gigantische Rechnersysteme benötigen. Das hat ja geklappt. Was unterscheidet Stable Diffusion so grundlegend von den anderen Modellen?

Prof. Dr. Björn Ommer

Unser Ziel war es, Generative KI leistungsfähig und gleichzeitig effizient zu machen, sodass gewöhnliche Nutzer und nicht nur Big-Tech Firmen Generative KI nutzen können. Stable Diffusion ist ein Diffusionsmodell wie andere aktuelle Text-zu-Bild-Generatoren. Der Unterschied ist, dass die anderen Diffusionsmodelle das Bild direkt aus Bildpunkten zusammensetzen und dadurch deutlich größer und rechenintensiver sind, um dieselben Aufgaben zu verrichten. Im Gegensatz dazu hat unser Ansatz zuerst eine effiziente Beschreibungssprache für Bilder gelernt, die lokale Bilddetails viel effektiver darstellen kann. Das Diffusionsmodell kann dann Bilder mittels dieser abstrakten Beschreibung viel effizienter generieren als direkt mit Bildpunkten. Unser Ansatz wurde dadurch so effizient, dass er selbst auf Smartphones läuft statt teure Spezialhardware oder ein Rechenzentrum in der Anwendung zu erfordern.

Prof. Dr. Björn Ommer

Vor unserer Entwicklung wurde KI von großen Firmen typischerweise verbessert, indem sie die Modelle vergrößert, also immer mehr Parameter hinzugefügt haben. Das ist teuer, weil es immer mehr Ressourcen erfordert, nicht nur während des Trainings, sondern auch in der Anwendung durch User. Kern unseres Ansatzes war die Beobachtung, dass nicht alle Details in einem Bild gleich wichtig sind. Wenn ich eine Wiese generieren möchte, interessiert mich die Farbe und ob das Gras kurz oder lang ist. Ich möchte aber nicht die Krümmung jedes einzelnen Grashalms angeben müssen. Wir haben deshalb den Prozess der Bildgenerierung in zwei Teile aufgeteilt. Die KI lernt im einen, das große Ganze, den Kontext zu bestimmen. Im anderen Teil werden dann die lokalen Details an Ort und Stelle ergänzt. Dies ist viel effizienter, als die KI direkt jeden einzelnen Pixel bestimmen zu lassen.

Wie lange hat dieser Prozess insgesamt gedauert?

Prof. Dr. Björn Ommer

Das ist ein Entwicklungsprozess, der nicht nur diese eine Veröffentlichung umfasst. Das waren sicherlich zwei oder drei Publikationen. Die Arbeiten haben bei uns so 2018 in dem Bereich begonnen. Zuerst haben wir uns nur mit menschlichen Figuren beschäftigt. Wir haben dann an weiteren Modellen geforscht. Kern war aber die ganze Zeit, dem Computer das Sehen beizubringen. Über viele Jahre war es ein bisschen, als wenn wir den Computer beim Lernen anschieben mussten. Wir haben geschoben, und im besten Fall ist er so ein bisschen mitgekommen, ist aber dann wieder etwas zurückgerollt. Und dann kam auf einmal ein Punkt, wo es anfing, dass wir geschoben haben und er ist weiter gerollt, als wir geschoben haben. Und auf einmal haben wir gesehen, wenn wir noch mehr Daten reingeben, rollt er noch weiter. Plötzlich fing die KI an, aus den Trainingsdaten Zusammenhänge zu lernen, die wir nicht explizit vorgegeben hatten und Konzepte wie Schatten und Reflexionen zu lernen.

Was waren die Herausforderungen, mit denen Sie zu kämpfen hatten?

Prof. Dr. Björn Ommer

Wenn man einer KI beibringen will, Bilder zu verstehen, Repräsentation zu lernen, dann ist das eine große Herausforderung. Ich habe mich immer gefragt, wie kann ich einem Modell beibringen, was beispielsweise Stühle ausmacht. Jeder Stuhl schaut anders aus. Es ist nichts in der Farbe, nichts in der Form da drin, was ein Sitzmöbel jetzt genau charakterisiert. Aber effektiv sind wir Menschen allesamt in der Lage dazu, das zu erfassen.

Wir haben uns viele Jahre als Community damit beschäftigt, Merkmale von Objekten zu beschreiben, vieles davon händisch zu machen. Dann kam das, was als Deep Learning bezeichnet wird, dass also von Pixeln, die reinkommen, bis zu der finalen Ausgabe alles trainiert wurde. Die KI lernt dabei automatisch, auf welche Merkmale es potenziell ankommen kann. Bei Generativer KI ist dieser Prozess auf den Kopf gestellt. Zuvor haben wir über Jahre dem Computer das Sehen beigebracht, indem wir so ein bisschen wie bei kleinen Kindern hingegangen sind und gesagt haben: „Hund, Hund, Hund, Katze, Katze, Katze" und dazu passende Bilder gezeigt haben. Aber es zeigt sich, dass das ein sehr mühevoller Prozess ist, für den ich nur relativ wenig Bilder mit Bildbeschreibungen zur Verfügung habe. Weiterhin erfasst die Annotation nur einen sehr kleinen Teil dessen, was eigentlich in so einer Szene vorhanden ist. Generative KI dreht das um. Hier haben wir ein sogenanntes selbstüberwachtes Lernen. Menschen können aus Bildern lernen, ohne dass jemand auf jedes Objekt zeigt und erklärt, was es eigentlich bedeutet. In unserem Fall lernt der Computer z. B. die Essenz einer Szene, indem er eine kompakte Beschreibung des Bildes lernt und gleichzeitig versucht, aus dieser das Bild zu rekonstruieren. So wie Kinder aus Puzzles lernen. Man gibt ihnen nur einzelne Teile und sie müssen diese Teile zusammensetzen und lernen dabei, dass der Kopf auf dem Rumpf ist und die Beine unterhalb des Rumpfes und wie diese zusammengehören. Die Herausforderung ist weiterhin, dass dieses Modell möglichst kompakt und gleichzeitig leistungsfähig ist.

Nachdem das Modell veröffentlicht wurde: Was waren die ersten Anwendungsfälle?

Prof. Dr. Björn Ommer

Das Erste war die Generierung von Bildern aus einer Textbeschreibung, die Vervollständigung einer Szene durch Auffüllen von Verdeckungen und die Stilisierung oder Verbesserung eines Bildes. Aktuell sind Videos und 3D-Szenen eine größere Herausforderung. Gleichzeitig sehen wir große Fortschritte, indem unser Modell als Repräsentation für Bildinhalte verwendet wird. Damit erschließen sich für unseren generativen Ansatz diskriminative Anwendungen, bei denen die gelernte Repräsentation nicht zu Synthese von Objekten, sondern zu ihrer Unterscheidung bzw. Klassifikation verwendet wird. Spannend ist auch die synthetische Generierung von zusätzlichen Trainingsdaten, für Klassen mit nur wenigen realen Daten. Obwohl wir eine KI trainiert haben, die Bilder generieren sollte, wurde so eine Repräsentation gelernt, die deutlich darüber hinausgeht. Insbesondere deswegen sprechen wir von einem Foundation Model. Dies sind Modelle, die deutlich über die Aufgaben und Probleme hinausgehen, auf denen sie trainiert wurden. Sie sind nicht auf eine spezifische Aufgabe trainiert. Vielmehr können sie einfach auf neue Fragestellungen angepasst werden. Diese allgemeine Repräsentation ist folglich eine Ermöglichungstechnologie für zukünftigen technischen Fortschritt.

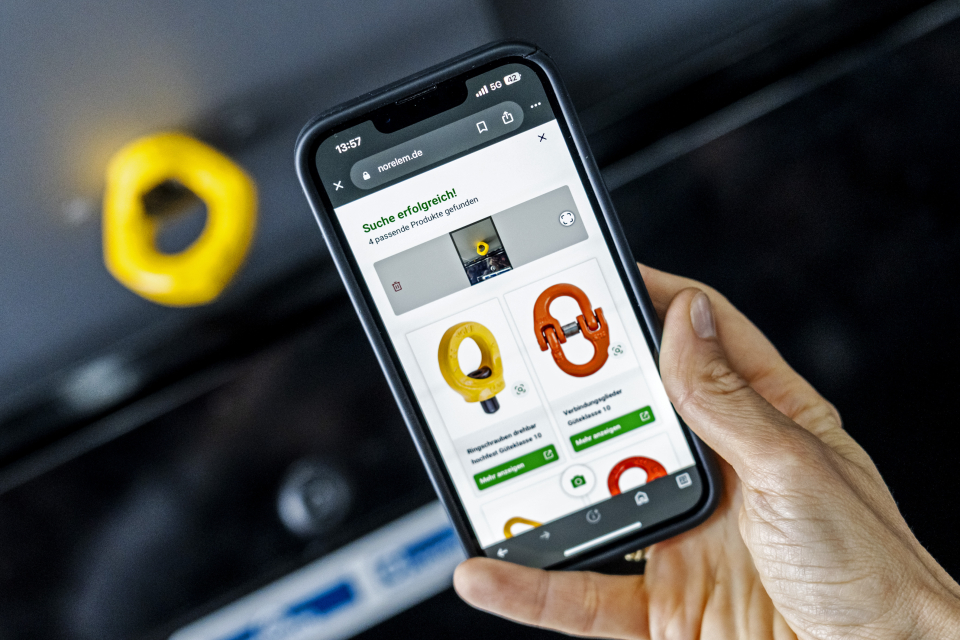

Dennoch hat sich auch eine ganz spezielle und spezifische Anwendung ergeben. Wie sind Sie bei nyris auf Stable Diffusion gekommen?

Dr.-Ing. Anna Lukasson-Herzig

Täglich kommt es millionenfach vor, dass jemand ein Teil in der Hand hält, was sie oder er dringend braucht und es leider nicht eindeutig mit Worten beschreiben kann und dadurch nicht identifizieren kann. Das ist genau das Problem, das wir lösen. Wir ermöglichen es, via Foto statt Text zu suchen. Damit, also mit der visuellen Suche, haben wir zunächst angefangen. Also der Zuordnung eines fotografierten Objektes zu einem bereits bekannten und in einer Datenbank hinterlegten Objekt. Hierfür nutzen wir Retrieval Models. Wichtig ist, in einem Bild zunächst das Objekt zu finden, also zu definieren, wo befindet sich überhaupt ein Fokusobjekt in diesem Bild? Es ist eben selten so, dass man etwas fotografiert und der Hintergrund total neutral ist. Stattdessen sind sehr häufig viele Objekte und auch andere Bauteile oder Sonstiges im Hintergrund vorhanden. Das heißt: Man muss erst mal lernen, wo ist im Bild ein Fokusobjekt enthalten? Und im nächsten Schritt, was ist dieses Fokusobjekt?

Und bei beiden hatten wir das große Thema, dass unsere Kunden sehr wenig Material zur Verfügung hatten. Die konnten uns nicht Millionen Daten zur Verfügung stellen, um unsere Modelle zu trainieren. Sie konnten weder sagen: „Wir haben Daten von Ersatzteilen, die vor neutralem Hintergrund dargestellt sind“ noch „Wir haben Bilder von Teilen, die vor einem unruhigen Hintergrund dargestellt sind“. Und schon gar nicht Bilder von Ersatzteilen, in denen definiert ist, wo eigentlich das Fokusobjekt ist. Und da haben wir relativ früh gesagt, wir brauchen dafür irgendeine Lösung und haben die Kunden gefragt: „Was habt ihr denn stattdessen? Wenn ihr keine Bilder habt, was habt ihr?" Und dann haben sie gesagt: „Wir haben CAD-Daten, davon haben wir genug." Und dann haben wir überlegt, dann lass uns etwas mit den CAD-Daten machen. Das sind Daten, die rein mathematisch die Geometrie eines Bauteils beschreiben und als Datei abgelegt werden. Es gibt bereits viele Technologien, welche diese CAD-Daten in ein Bild verwandeln. Aber dies ist zum einen relativ aufwendig, mit manuellem Aufwand verbunden, und die Ergebnisse sehen nicht echt aus.

Die Bilder sind ziemlich platt, haben keine Lichtspiele und vor allen Dingen immer einen gleichmäßigen Hintergrund. Das ist ziemlich weit weg von der Realität. Aber das war ein Anfang, damit konnten wir starten und haben mit diesen Daten die ersten Netze trainiert. Vorteil dieser Daten ist, dass sie immer perfekt annotiert sind, da die Zuordnung in den CAD- Daten enthalten ist. Damit haben wir jedoch keine sehr gute Accuracy, also Suchgenauigkeit erreicht. Daher haben wir überlegt, was gibt es da noch? Wir haben das Paper von Björn gefunden und mit dem Modell angefangen und gesagt: „Lass uns mal als Condition, also als Freiheitsgradbeschränkung, das CAD-Modell eingeben und sagen: „Bitte mal mir ein Bild, aber nicht ein Bild von irgendetwas, sondern bitte mal mir die Oberfläche auf diese Form drauf. Und diese Oberfläche soll aus Gusseisen sein oder aus Stahl oder aus Kunststoff. Damit konnten wir sehr viele Bilder generieren und diese dann fürs Training nutzen. Das Tolle war, dass wir diese nicht annotieren mussten. Dann haben wir ganz viele Bilder ohne den CAD-Input generiert, also gesagt: „Stell Zahnräder vor einem Holzhintergrund dar" oder „Stell unterschiedliche Bauteile dar." Wir haben nur die Unterschiede zwischen den einzelnen Bildern und die unterschiedlichen Features, die man sah, genutzt, um die Modelle zu trainieren. In der Summe haben wir über 100 Millionen Bilder synthetisch hergestellt, um diese für das Training zu nutzen. Dies wäre auf klassisch physische Weise niemals möglich gewesen oder hätte jahrelang gedauert. Hier ist es wichtig zu erwähnen, dass diese Entwicklung seitens der Europäischen Union, also dem European Innovation Council, finanziell gefördert wurde, wofür wir sehr dankbar sind. Ohne diese Finanzmittel wären wir nicht in der Lage gewesen, die Computerpower und die notwendige Anwendungsforschung zu stemmen.

Was daran ist der kostspielige Faktor?

Dr.-Ing. Anna Lukasson-Herzig

Die Cloud-Kosten, die man braucht, um das Ganze durchzurechnen. Es ist ja eine mathematische, hochkomplexe Rechnung, die da stattfindet, und da entstehen ziemlich hohe Kosten. Aber es lohnt sich. Als wir das Projekt gestartet haben, hatten wir uns am Anfang vorgenommen, am Ende des Projektes 10.000 Bilder am Tag generieren können, das schien uns schon eine wahnsinnige Zahl. Und in der gleichen Zeit hat sich Stable Diffusion deutlich weiterentwickelt, sodass wir viel schneller vorwärtskamen als geplant.

Welches Problem lösen Sie mit Ihrer Applikation, das vorher schwer zu lösen war?

Dr.-Ing. Anna Lukasson-Herzig

Die Applikation an sich besteht aus zwei zusammengesetzten Technologien. Einmal die Generierung der Daten und dann die visuelle Suche, die dann in einem Bild ein Bauteil erkennt. Ohne unsere Technologie passiert das heutzutage häufig über viele Telefonate, Zurückfahren zum Office, Senden von Bildmaterial, Warten auf Info, teilweise dauert es bis zu 5 Tage, ein Bauteil zu identifizieren.

Es passiert Millionen Mal jeden Tag, dass irgendwo eine Person an einer Maschine arbeitet oder sie wartet und ein Teil identifizieren muss, aber nicht genau weiß, um was es sich handelt. Weil die Anleitung nicht zur Hand ist, weil die Person die Bedienungsanleitung nicht versteht oder die Sprache nicht spricht. In den Bedienungsanleitungen sind oft sogenannte Explosions-Zeichnungen enthalten, welche schwierig zu lesen sind. Oder es sind Teile verbaut, die eigentlich gar nicht in der Maschine sein sollten. Dies kommt vor, wenn bei der Inbetriebnahme nicht die richtigen Teile angeliefert wurden und man dann improvisieren musste und etwas anderes einbauen musste. Es gibt 1.000 Gründe, weswegen es schwierig ist, Bauteile zu identifizieren. Es dauert bis zu fünf Tage und beschäftigt viele Abteilungen und Menschen in einem Unternehmen, die teilweise nur für diese Aufgabe abgestellt werden. Und diese Menschen sind Produktexperten, die man eigentlich dringend woanders braucht. Es ist ein Märchen zu glauben, dass wir denen die Jobs wegnehmen. Dies sind monotone Arbeiten, die von Menschen gemacht werden müssen, die sehr viel Erfahrung und ein sehr tiefes Produktwissen haben und bei denen es sehr nützlich wäre, wenn man sie woanders einsetzen könnte als in der Recherche nach Ersatzteilen. Diese Ressourcen stellen wir frei und machen es deutlich einfacher, indem die Maschine diese Identifikation übernimmt und sie sich anderen Aufgaben widmen können.

Was versprechen sich Ihre Kunden konkret von der Anwendung?

Dr.-Ing. Anna Lukasson-Herzig

Es gibt unterschiedliche Situationen, in denen Ersatzteile oder Bauteile erkannt werden müssen. Der häufigste Fall ist der, wenn eine Maschine gewartet wird. Da ist es sehr hilfreich, wenn diese ziemlich schnell gewartet wird, denn je häufiger oder je länger eine Maschine steht, umso weniger Geld kann man mit ihr verdienen. Diese Downtimes führen dazu, dass die Ausnutzung der Maschine zu niedrig und die Kosten der Maschine zu hoch sind. Je schneller man diesen Job erledigt, desto besser. Mit der visuellen Identifikation kann man das deutlich schneller erledigen. Wir haben in Tests gezeigt, dass wir bei einem Maschinenbauer die Anzahl der Doppel-Fahrten halbieren konnten. Dies sind Wartungsjobs, bei denen ein doppelter Vorortbesuch notwendig war, da die notwendigen Ersatzteile beim ersten Besuch nicht identifiziert werden konnten. Die Techniker mussten zum Office zurückfahren, und dort fragen: „Was ist das für ein Teil? Wo bekomme ich das her?“ Um dann festzustellen, dass sie ein Alternativbauteil bereits im Auto dabeihatten. Die Anzahl dieser Fahrten zu halbieren ist wahnsinnig viel.

Ein zweiter häufiger Fall ist in der Konstruktion. Wenn Maschinenkonstrukteure eine neue Maschine konstruieren wollen, möchten sie schnell für sich entscheiden, welche Standard-Bauteile in dieser Maschine eingebaut werden sollen. Zum Beispiel beim Automobil, dort sind Konstrukteure oft wirklich physisch vor Ort in einer Werkstatt, um den ersten Prototypen zu bauen. Sie greifen in Standardbauteilkästen rein und entscheiden, was sie an dieser Stelle brauchen. Dann gibt es andere Sachbearbeiter, welche diese Teile und die möglichen Lieferanten identifizieren müssen. Wenn diese nicht schnell genug ein bestimmtes Teil finden, entscheiden sie sich vielleicht für ein Wettbewerbsteil oder für ein weniger qualitativ hochwertiges Teil. So geht Umsatz verloren für die Unternehmen, die diese Teile liefern. Und die Guten, also die Frontrunner, möchten es ihren Nutzern so einfach wie möglich machen, damit diese am schnellsten ihre Teile identifizieren und sich deswegen auch für sie entscheiden. Das heißt, für diese erhöhen wir den Umsatz.

Gibt es Sorgen oder Bedenken von Kunden, was IP-Rechte angeht, dass ihre Arten von Ersatzteilen sichtbar sind?

Dr.-Ing. Anna Lukasson-Herzig

Wenn man mit CAD-Daten hantiert, gibt es immer diese Themen. Für unsere Zwecke brauchen wir nur die Außenhülle des Modells. Wir brauchen nicht die gesamte IP der Bauteile, sondern nur das von außen Sichtbare. Dies ist bereits ein Vorteil. Trotzdem ist es wichtig, auch hier die Schutzrechte zu wahren. Es ist zum Beispiel ein klarer Wunsch unserer Kunden, dass die Abbildungen, welche im Netz kursieren, nicht ganz der Realität entsprechen, um eine Reproduktion zu erschweren. Hier ist die Generierung der Fotos via Stable Diffusion extrem hilfreich, weil hier automatisch ein paar Fehler in die Abbildungen eingebaut werden, welche in der Realität gar nicht da sind. Die Wissenschaft nennt es Halluzination. Das führt dazu, dass diese Bilder nicht exakt der Realität entsprechen. Für unsere Erkennungs-Engine ist dies jedoch egal. Sie hat genug sichtbares Material, um das Bauteil wiederzuerkennen. Aber es ist nicht detailgetreu genug, um das im 3D-Druck oder mit anderen Produktionsprozessen nachbauen zu können.

Wie ist das insgesamt mit IP-Rechten? Es gibt ja auch im künstlerisch kreativen Bereich Diskussionen um Generative Bild-KI und dass Urheberrechte verletzt werden. Wie sind Sie damit umgegangen?

Prof. Dr. Björn Ommer

Für mich wäre wichtig, diese Fragestellung zuerst mal in der Öffentlichkeit diskutieren zu können. Vor unseren Arbeiten zu Stable Diffusion wurde die Bedeutung von Daten für das Training von KI in der Öffentlichkeit viel zu wenig diskutiert. Durch die Offenlegung unserer KI und ihres Trainingsprozesses wurde es transparent und konnte gesellschaftlich diskutiert werden. Nun konnte jeder dieses System direkt ausprobieren, Inhalte mit dem Computer produzieren, wie er es zuvor nicht konnte. So kam die Frage in der breiten Öffentlichkeit auf, woher denn diese Fähigkeit der KI kommt, was wiederum auf Grund unseres offenen Ansatzes nachvollzogen werden konnte. Über Jahre haben die großen Tech-Firmen auch Gratis-E-Mails und weitere Dienste angeboten. Nicht nur aus Nettigkeit, sondern auch, weil sie dadurch Trainingsdaten bekamen, die sie dann weiter zum Training ihrer Systeme genutzt haben. Aber es ist viel zu wenig diskutiert worden, was mit unseren Daten dort geschieht. Wir waren in unserem Forschungsprojekt sehr transparent, wie das mit den Daten abgelaufen ist. Mir persönlich ist es sehr wichtig, dass kreative Kunstschaffende, die Content generieren, eine Möglichkeit haben, zu entscheiden, was mit ihren Daten passiert. So sind in letzter Zeit einige Lösungsansätze diskutiert worden.

Bei den großen Bilddatensätzen sehe ich kritisch, dass gerade große Firmen, um Sicherheit zu haben bezüglich Intellectual Property, häufig auf sehr große Deals mit Content-Agenturen setzen. Sie sind dadurch in der Lage, Deals herauszuhandeln, die kleinere Start-ups und Firmen nicht herausholen können, bei denen aber umgekehrt die Kunstschaffenden schlussendlich nicht viel davon bekommen werden. Der Großteil des Geldes bleibt dann doch wieder bei den größeren Firmen, die diese Rechte verwalten. Und da sollten wir nach Möglichkeiten suchen, dass das Geld wirklich da ankommt, wo es auch gebraucht wird. Hier gibt es noch Diskussionsbedarf. Im Moment sieht man bei größeren Firmen, dass sie sich natürlich absichern wollen. Aber ob der Weg dorthin im Moment wirklich zielführend ist, das möchte ich hier oder da bestreiten.

Dr.-Ing. Anna Lukasson-Herzig

Hinzukommt, dass die Industrie Angebote braucht, bei denen ihre Daten komplett closed verwendet werden und vollständig geschützt sind. Hierfür gibt es am Markt nur wenige Angebote. Wir bieten ein Komplettsystem an, bei dem unsere Kunden ihre Daten an uns speisen und wir diese nur für ihre spezifische Engine benutzen und sonst für niemanden. Dies ist für uns sehr wichtig, das ganze System ist so aufgebaut, dass es gar nicht anders geht, heißt, dass ein Missbrauch der Daten nicht stattfinden kann.

Prof. Dr. Björn Ommer

Ich denke, dass wir bei kritischer Technologie in der Vergangenheit Wert darauf gelegt haben, dass zumindest kritische Teile davon offengelegt worden sind. Wir sehen das beim Internetprotokoll und anderer Technologie, von der wir allesamt abhängig sind. Beispiel Medizin: Niemand würde wohl gerne eine Tablette schlucken, wenn ich sage: „Das funktioniert in 90 Prozent der Fälle, aber ich kann dir nicht genau sagen, warum. Das ist mein Geheimnis." Da müssen zumindest den Regulierungs- und Zulassungsbehörden elementare Zusammenhänge mitgeteilt werden und Einsicht gewährt werden. Und ich glaube deswegen auch, dass - nicht komplett, aber in kritischen Bereichen - Open Source, gerade auf Seiten der Foundation Models, für uns wichtig sein wird. Wir brauchen das gerade in unserer offenen demokratischen Gesellschaft, um dafür zu sorgen, dass möglichst viele Menschen daran partizipieren können und Transparenz in kritischen Bereichen dieser Technologie wird für breite öffentliche Akzeptanz und Partizipation essenziell sein. Das war einer der Gründe, warum wir uns dazu entschlossen haben, bei Stable Diffusion einen Open Source Ansatz zu verfolgen. Es bedeutet nicht, dass andere, beispielsweise nyris, damit kein Geld verdienen können. Es bedeutet nicht, dass auf einmal alles in der IT Open Source sein sollte. Kritische Komponenten von Generativer KI können offengelegt werden, ohne die Wertschöpfungskette einzureißen, ganz im Gegenteil.

Wie sehen Sie die Entwicklung von Stable Diffusion in der Zukunft, was den gesellschaftlichen Mehrwert und die Entwicklungspotenziale angeht, die für uns alle relevant sein werden?

Prof. Dr. Björn Ommer

Unser Ziel ist, Generative künstliche Intelligenz zu demokratisieren, also dafür zu sorgen, dass möglichst viele Menschen daran partizipieren können und nicht nur einige wenige große Firmen den Zugang haben. Dies schafft technologische Souveränität in einem zukünftig kritischen Bereich für unsere Gesellschaft und Wirtschaft. Der wesentliche Punkt von nyris ist, diese effiziente Nutzung dieses Foundation-Models Stable Diffusion für die Bildsuche voranzutreiben.

Die Weiterentwicklung zielt einerseits auf eine weitere Effizienzsteigerung der KI und andererseits auf eine Verbesserung der Qualität ab. Ich finde die Geschwindigkeit der Verbesserung und Verbreitung von Stable Diffusion seit der Veröffentlichung schon erstaunlich. Das automatische Bildverstehen und -editieren wird jetzt stark untersucht. Wir selbst beschäftigen uns intensiv mit dem Bereich der Videogenerierung und der umgekehrten Richtung, dem Verstehen von Videos. Weitere Arbeiten zielen auf die Synthese und Analyse dreidimensionaler Szenen ab. Video und 3D sind große Fragestellungen, weil sie natürlich noch rechenaufwendiger sind, als nur ein einzelnes Bild zu generieren.

Dr.-Ing. Anna Lukasson-Herzig

Wir Menschen kommunizieren viel visuell. Und das ist extrem effizient. Also, wenn wir uns treffen und du krank wärst, müsstest du es mir nicht sagen. Ich würde sofort sehen, dir geht es schlecht und dann würde ich mich dementsprechend anders verhalten.

Die Kommunikation, die wir Menschen momentan mit Maschinen führen, ist sehr umständlich. Wir haben mehrere Übersetzungsschleifen, bis dann wirklich bei der Maschine ankommt, was wir eigentlich von ihr wollen. Und diese Kommunikationswege zu vereinfachen durch Computer Vision, die viel mehr Informationen in der gleichen Zeit übertragen kann, macht die Information viel einfacher analysierbar. Stellen wir uns mal vor, dass wir uns die Mühe gemacht hätten, ein Foto, das wir heute gemacht haben, per Text vollständig zu beschreiben. Das wären mehrere A4-Seiten Text. Eine KI zu entwickeln, welche diesen langen Text richtig interpretiert, wäre extrem schwierig. Sodass jetzt schon sichtbar ist, dass die Welt, in der wir leben, zu erfassen, zu interpretieren und zu analysieren, für eine Maschine per Bild deutlich einfacher ist. Deswegen glaube ich, dass diese Tausende von Schleifen und Übersetzungen, die wir heute noch haben, durch Computer Vision wegfallen werden. Und wir mit Maschinen über diese visuellen Kanäle viel einfacher kommunizieren werden. Das ist ein Riesenpotenzial und wir sind noch ganz am Anfang, so ungefähr in dem Stadium, wo man sagen würde: „Der Markt sind fünf PCs pro Jahr“. Die Zukunft wird uns zeigen, wie groß das Potential wirklich ist."

Wird sich nyris in der Zukunft weiterentwickeln mit Stable Diffusion?

Dr.-Ing. Anna Lukasson-Herzig

Auf jeden Fall! Wir haben Riesensprünge gemacht und Dinge geschafft, die wir eigentlich erst in ein paar Jahren gesehen haben. Insofern freut uns das natürlich. Und wir wollen uns weiterentwickeln. Gerade mit dem Fokus Maschinenbau gibt es noch sehr viel Potenzial, zum Beispiel in Bezug auf Tiefenschärfe und 3D. Tiefenschärfe an sich ist sehr schwierig für Maschinen, weil man ihnen nur sehr langsam beibringen kann, dass etwas, das kleiner aussieht, einfach nur weiter weg ist, aber eben nicht kleiner. Das verstehen wir Menschen, obwohl wir keine Abstandsmessung in den Händen haben, aber das verstehen Maschinen nicht. Tiefenschärfe, 3D-Sicht und die Größe abschätzen, das können wir alles noch nicht. Und wenn sich das weiterentwickelt, können wir diese Welt natürlich noch genauer erfassen und noch effizienter mit dieser Technologie arbeiten.

Was kann man mit Stable Diffusion noch tun?

Dr.-Ing. Anna Lukasson-Herzig

Es gibt natürlich in der Medizin viel, weil man da auch das Thema hat, dass man schwer an Daten rankommt, der Datenschutz kompliziert ist, die Unterschiede zwischen den einzelnen Bildern marginal sind, dadurch braucht man mehr Trainingsmaterial. Und es ist schwierig, diese zu bekommen. Man wünscht sich ja auch nicht, dass man mehr Krebspatienten hat, nur damit man mehr Trainingsmaterial hat. Da gibt es noch viele Möglichkeiten, mit synthetischen Daten die Lücken zu schließen.

In der Summe denke ich an das Thema Mensch-Maschine-Kommunikation. Man spricht viel über Medien und Werbung, wenn man über diese Technologie nachdenkt. Ich sehe deutlich mehr Potenzial im industriellen Umfeld. Da gibt es einfach diese riesige Anzahl an Daten und den Auftrag, diese visuell darzustellen. Wir sprechen zum Beispiel mit Abteilungen zur Ausbildung von neuen Mitarbeitern, die uns sagen, dass der Lehrstoff sich heute viel schneller entwickelt. Sie müssen heute in einer Drei-Jahres-Ausbildung viel mehr Material bearbeiten als früher. Und wir müssen neue Wege finden, das beizubringen. Das geht visuell einfacher, schneller und funktioniert besser. Ich glaube, das industrielle Umfeld hat viel mehr Möglichkeiten, mit diesen Technologien Werte zu schaffen, als wir das wir heute schon sehen.

Prof. Dr. Björn Ommer

Wir Menschen haben uns immer Technologie geschaffen, um unsere Beschränkungen zu kompensieren. Wir sind nicht die schnellsten Läufer. Wir können nicht die schwersten Dinge tragen und vieles mehr. Dafür haben wir uns immer technische Hilfsmittel geschaffen. Und künstliche Intelligenz sehe ich als ein weiteres Hilfsmittel. Steve Jobs hat den Computer „bicycle for the mind" genannt. Die Generative KI ist dann schon eher eine Allradfahrzeug.

Wir Menschen haben verstanden, dass wir uns Dinge nicht gut merken können, nicht gut rechnen können. Dafür nutzen wir den Personal Computer. Aber Generative KI macht den Personal Computer noch viel persönlicher. Bisher waren alle Applikationen darauf von der Stange und der Personal Computer war nur sehr begrenzt „personal“. Wir hatten alle dieselben Apps. Mit Generativer KI haben wir jetzt die Möglichkeit, dass der Personal Computer mich persönlich viel besser versteht. Er versteht, was ich noch nicht verstanden habe, kann mir das erklären, was ich noch nicht verstanden habe und mich dort abholen, wo ich mich im Moment befinde. Dies macht den PC zu einem viel mächtigeren Werkzeug. Bei bisherigen technischen Durchbrüchen kam danach die nächste Welle, die komplett neue Werte geschaffen hat durch eine Technologie, die vorher nicht da war und ohne die dies auch nicht möglich gewesen wäre. Und als genau das sehe ich Generative KI und ich hoffe stark, dass wir diese Wertschöpfung in Deutschland nicht verpassen.

Unser primäres Ziel sollte es sein, menschliche Fähigkeiten zu ergänzen und nicht zu ersetzen. Betrachten wir beispielsweise die Arbeitswelt. Für den Großteil der Herausforderungen, die wir bei Generativer KI diskutieren, ist die KI nur ein Vergrößerungsglas für Probleme, die wir schon die ganze Zeit haben. Wenn es mir bei meinen Angestellten primär um Geschwindigkeit geht, wenn die Mitarbeiter austauschbar sind und wenn ihre Tätigkeiten keine großen Implikationen haben, dann habe ich meine Mitarbeiter schon zu Maschinen gemacht. Natürlich werden die vermutlich als Nächstes durch eine Maschine ersetzt, wenn ich sie schon vorher als solche behandelt habe. Die Frage sollte eher sein, wie eine KI Menschen helfen kann, ihr genuines Potenzial besser zu heben. Es gibt genügend Teilaufgaben, bei denen Menschen sich wie Maschinen verhalten müssen, um diese gut zu erledigen und dadurch ermüden und ihre Zufriedenheit und die Qualität der Arbeit leidet. Wenn KI helfen kann, dass Mitarbeiter sich deutlicher auf ihre Stärken, auf das, was sie von anderen und der Maschine absetzt, fokussieren können, können sie hinzugewinnen und auch in einem international kompetitiven Umfeld bestehen, das diese neue Technologie einsetzt. Umgekehrt sehen wir viele Bereiche, bei denen es effektiv an Arbeitskräften fehlt. Nehmen wir nur die medizinische Versorgung und Früherkennung von Krankheiten. Eine engmaschigere Versorgung kann Leben retten und doch fehlt es weltweit an ärztlicher Versorgung. Hier wäre es essenziell, wenn eine KI die dünne ärztliche Versorgung auf die kritischen Fälle fokussiert.

Dr.-Ing. Anna Lukasson-Herzig

In der Historie hat man gesehen, dass Automatisierung Jobs geschaffen und nicht vernichtet hat. KI, wie wir diese heute nutzen, ist eine andere Ebene der Automatisierung. Automatisierung hat schon immer zu mehr Jobs geführt und nicht zu weniger, selbst in der jüngsten Vergangenheit. Wenn man sich zum Beispiel zwischen 2010 und 2019 die Anzahl der Industrieroboter anschaut, die in Deutschland im produzierenden Gewerbe implementiert wurden, und gleichzeitig die Zahl der Jobs im gleichen Bereich, geht das Hand in Hand. Die Industrieroboter führen nicht dazu, dass die Jobs weniger werden, sondern, dass es mehr Jobs gibt. Wieso? Weil die Industrieroboter dazu führen, dass die Unit Costs für eine produzierte Einheit niedriger werden. Wenn die Unit Costs niedriger werden, weil die Roboter das günstiger können und schneller und fehlerfreier, wird der Prozess günstiger, dann kann man einen besseren Preis am Markt erzielen. Wenn man bessere Preise am Markt erzielt, verkauft man mehr. Wenn man mehr verkauft, macht man mehr Umsatz. Was macht man mit mehr Umsatz? Man entwickelt sich weiter, entwickelt neue Produkte, neue Angebote und stellt neue Mitarbeiter ein. Die Jobs werden da verloren gehen, wo KI NICHT eingesetzt wird. Diese Unternehmen werden Schwierigkeiten am Markt bekommen, weil deren Unit Costs zu hoch werden, weil damit ihre Produkte zu teuer werden und nicht mehr wettbewerbsfähig sind.

Prof. Dr. Björn Ommer

Es ist natürlich wichtig, dass wir die nächste Generation genau darin ausbilden, wie man Generative künstliche Intelligenz nutzen kann, um auf dem internationalen Arbeitsmarkt zu bestehen und kompetitiv zu sein und dabei die Werte zu schaffen, die sich genau durch diese Technologie ergeben. Dazu müssen wir sehr vorne anfangen. Jetzt reden wir nicht nur davon, Programmieren beizubringen, sondern Generative künstliche Intelligenz wirkmächtig einzusetzen. Das wird von klein an in Zukunft immer wichtiger werden, wenn wir möchten, dass die nächste Generation international bestehen kann.

Dr.-Ing. Anna Lukasson-Herzig

Das ist auch jetzt viel einfacher. Bildung ist ja auch sehr demokratisch geworden, was schön ist. Es können sich Menschen in der ganzen Welt hervorragend ausbilden lassen über das Internet, was auf der einen Seite toll ist. Aber auf der anderen Seite natürlich dazu führt, dass wir in Deutschland nicht mehr ein Alleinstellungsmerkmal dadurch haben, dass wir jungen Menschen eine gute Ausbildung anbieten können. Und gerade in diesem Feld gibt es Entwicklungsländer, die extrem gut ausgebildete Mitarbeiter auf den Markt bringen. Und da müssen wir wach bleiben und uns weiterentwickeln.

Kritisch gefragt: Wenn nyris ein Modell nutzt, das sowieso überall verfügbar ist, was ist der Wettbewerbsvorteil gegenüber anderen, die vielleicht auch Stable Diffusion nutzen könnten?

Dr.-Ing. Anna Lukasson-Herzig

In jedem Technologiefeld ist es notwendig, dass man aus dem, was die Grundlagenforschung hervorbringt, ein Produkt entwickelt, das wirklich für einen Endkunden verwendbar ist. Unsere Kunden, die heute nyris nutzen, sind nicht in der Lage, Stable Diffusion zu nutzen. Wir müssen die Technologie anpassen, ein Produkt entwickeln und das auf die Straße bringen, damit unsere Kunden diese Technologie für sich nutzen können. Das bedeutet als allererstes, dass wir diese Technologie für diesen besonderen Use Case trainieren, also Daten generieren, die das Know-how beinhalten, das wir von unseren Kunden gelernt haben. Und dann trainieren wir mit diesen Daten die Modelle so, dass sie für diesen Use Case besonders gut funktionieren. Das bedeutet auch, dass wir die Tech für unsere Kunden verfügbar machen, also Schnittstellen darstellen, Datenconnections darstellen, uns mit SAP und allen gängigen Plattformen und Software, die unsere Kunden benutzen, connecten, damit sie das so einfach wie möglich für sich nutzen können. Für die Menschen, welche in einem Unternehmen diese Systeme verwalten, muss es so einfach wie möglich sein, diese Technologie zu nutzen, heißt, sie sollen nicht coden müssen, kein machine-learning betreiben, keine Data Scientists einstellen müssen und auch die ganzen Daten, die sie uns zur Verfügung stellen, nicht aufräumen müssen. Das machen wir für sie und wir machen das sehr effizient, da wir uns vollständig auf diese Aufgabe fokussieren. Für uns ist das unser Core Business. Wir bereiten die Straße vor, auf der sie das Auto fahren und stellen es in der für sie einfachsten Form zur Verfügung.

Sind Sie der Konkurrenz einen Schritt voraus, weil Sie das früher erkannt haben und früher Ihre KI so trainieren konnten, dass Sie da einen deutlichen Vorteil gegenüber anderen haben?

Dr.-Ing. Anna Lukasson-Herzig

Wir haben einen deutlichen Vorteil dadurch, dass wir das frühzeitig als Use Case gesehen haben. Wir haben anfangs eine Technologie gesucht, an die wir andocken wollten. Wir hatten gar nicht vor, das selber zu entwickeln, und gedacht, dass es schon irgendwas geben wird und wir docken da einfach an. Und dann haben wir gesehen, dass alles, was es auf dem Markt gibt, nicht wirklich skaliert. Das kann vielleicht 100.000 Daten durchsuchen, aber wir brauchen Millionen. Das Bestehende reicht nicht aus. Und dann haben wir irgendwann entschieden, wir machen es jetzt selber, das war 2015, und haben von Anfang an alles komplett aufgebaut mit dem Blick darauf, dass es sehr hoch skaliert. Es hat natürlich extrem geholfen, dass mein Bruder bei Amazon gearbeitet hat und da viel mitgenommen hatte, gerade was Skalierung betrifft. Und jetzt zahlt sich das aus: Die Kundenbeziehungen und die ganzen Jahre, in denen wir die Entwicklung mitgemacht haben, alle Papers gelesen, alles immer wieder neu haben durchlaufen lassen und angepasst haben und geschaut, was funktioniert besser, was funktioniert schlechter. Es waren viele Schleifen und eben die jahrelange Arbeit, die dazu geführt hat, dass wir jetzt auf sehr stabilen Füßen stehen.

Prof. Dr. Björn Ommer

Für die Nutzbarmachung von Generativer künstlicher Intelligenz ist es im Endkundenkontakt enorm wichtig, die entsprechende Vertrauensbasis zu haben. Es sind wichtige Daten, die ausgetauscht werden. Weil nyris so früh in diesem Geschäft war, konnten sie früh Vertrauen aufbauen und nun davon profitieren. Dies haben sie großen ausländischen Tech-Konzernen voraus. Die schicken sich natürlich jetzt auch an, in dieser weiteren Nutzbarmachung mit der aktuellen Welle von Foundation Models vorne dabei zu sein. Aber die Technologie an Kunden heranzuführen erfordert Vertrauen, und da hat eine deutsche Firma, die vorne dran ist und schon lange da war, ein Alleinstellungsmerkmal, was andere nicht haben und das habe ich bei nyris von vornherein zu schätzen gewusst.

Ein anderer Aspekt ist die Ressourceneinsparung. Gibt es da eine Zahl, wie viel an fossilen Brennstoffen eingespart wird? Wie viele Kilowattstunden kann man weniger Strom verbrauchen, wenn man mit diesen Modellen arbeitet statt mit den klassischen?

Dr.-Ing. Anna Lukasson-Herzig

Schätzungen haben wir dazu gemacht. Wir haben einen Footprint von 83 Tonnen CO2-Emissionen pro Jahr als Unternehmen und das Ziel, das zu senken. In den neuesten Reports von Google und Microsoft liest man: Microsoft hat die CO2-Emissionen um 30 Prozent erhöht, durch OpenAI und Google um 48 Prozent. Das sind schon heftige Zahlen. Und es ist schwierig, das exakt zu benennen, weil die nicht sehr transparent sind. Bei Stable Diffusion können wir sehr genau sagen, wieviel CO2-Emissionen die Generierung von einem Bild erzeugt. Für Microsoft können wir das nicht so genau sagen. Aber aus diesen 30 Prozent Plus bei Microsoft und 48 Prozent plus bei Google kann man schon ziemlich gut ableiten, was es an CO2 bedeutet, dieses enorme Training der Modelle und die Nutzung, die sie jetzt haben, zu bedienen. Da sind wir durch unsere Nutzung von Stable Diffusion mit unseren Berechnungen auf einen Faktor von deutlich mehr als 100 gekommen. Hinzu kommt die Wahl des Datacenters. Es gibt bereits klimaneutrale Rechenzentren, welche mit Ökostrom und Wasserkühlung arbeiten, was deutlich effizienter als Luftkühlung ist, da Wasser mehr Wärme aufnimmt und man diese auch speichern und wiederverwenden kann. Das von uns genutzte Data-Center befindet sich in einem Hochhaus in Frankfurt und wurde von einem Dresdner Unternehmen entwickelt. Die erzeugte Wärme wird für die Warmwasserversorgung und Heizung des Gebäudes verwendet, wodurch fossile Energie eingespart wird. Auch solche Maßnahmen tragen deutlich zur Reduktion der CO2 Emissionen bei. „Sustainable AI“ ist sicherlich ein Fokus, der in Europa mehr Beachtung findet als woanders und sich dadurch hoffentlich zu einem USP entwickelt.

Wurden dazu Berechnungen gemacht am Lehrstuhl?

Prof. Dr. Björn Ommer

Der Trainingsaufwand der KI entsprach einigen wenigen Interkontinentalflügen. Ich denke, die wenigsten Interkontinentalflüge sind vermutlich so produktiv wie es das ursprüngliche Training von Stable Diffusion gewesen ist. Nichtsdestotrotz gibt es noch viel zu tun, um künstliche Intelligenz im Training und in der Anwendung noch effizienter zu machen. Gerade das Training bereitet uns noch Kopfschmerzen. Wir brauchen dafür eine Menge an Grafikkarten, GPUs sagt man dazu. Die Rechenpower haben wir in Deutschland nur ungenügend zur Verfügung. Und wir sind natürlich bemüht, diesen Hardwarebedarf weiter zu reduzieren, um Souveränität gewährleisten zu können. Es gibt noch eine Menge offene Fragestellungen. Die aktuellen Ergebnisse stimmen uns zuversichtlich. Aber es ist noch ein Weg.

Inwieweit lernen Sie als Team voneinander, gibt es gegenseitige Impulse, die Sie gleichsam voranbringen?

Dr.-Ing. Anna Lukasson-Herzig

Den Austausch und die Gespräche mit Björn genieße ich sehr. Für mich persönlich und für uns bei nyris ist es sehr wichtig, stets sehr nah an der aktuellen Grundlagenforschung zu sein. Daher haben wir Björn gebeten, Teil unseres Tech Advisory Boards zu werden. In diesem Zusammenhang möchten wir auch gemeinsam an Forschungsthemen arbeiten, worauf ich mich sehr freue. Zudem teile ich mit Björn, die „Mission“ KI in EUROPA für die Welt zu entwickeln sowie unseren eigenen Europäischen USP zu etablieren. Wir sind beide Eltern und überzeugt davon, dass Wohlstand in Europa nur mit einer starken Position im Bereich KI haltbar ist. Hier motivieren wir uns stets gegenseitig und zeigen, dass KI relevant, nachhaltig und nicht wahnsinnig teuer sein kann. Und damit für viele einfach zugänglich und tatsächlich nutzbar. Wir sind davon überzeugt, dass dadurch der Nutzen dieser Technologie viel schneller und breiter gehoben werden kann.

Prof. Dr. Björn Ommer

Anna hat mit ihrer Firma sehr früh auf das Potential einer neuen Technologie gesetzt und mit dieser Vision ein sehr gefragtes, lukratives Anwendungsfeld erschlossen. Wie meine Gruppe in der Forschung musste sie es im Business mit den großen internationalen Konkurrenten aufnehmen und war dabei erfolgreich. Ihr Gespür für diese offenen Türen finde ich inspirierend. Auch wurde in den letzten Jahren Deutschland im Bereich von IT immer häufiger als hoffnungsloser Fall abgeschrieben. Dabei geht unter, dass der technologische Umbruch durch Generative KI gerade für Start-ups und dynamische kleine und mittelgroße Firmen genau jetzt einzigartige neue Chancen bietet. Anna hat gezeigt, dass die frühe, mutige Investition in moderne KI und ein direkter Kundenkontakt die Grundlage für erfolgreiche Firmengründungen in Deutschland sein kann. Wir brauchen mehr solche Vorbilder.

Wenn Sie gerade nicht das tun, wofür Sie nominiert worden sind, was machen Sie dann?

Dr.-Ing. Anna Lukasson-Herzig

Die meiste Zeit schlafen. Als Gründerin und Mutter von zwei, bleibt extrem wenig Zeit für andere Sachen. In diesen seltenen Momenten bin ich am liebsten in den Bergen, am allerliebsten in der Steiermark oder der Schweiz und übernachte irgendwo oben auf einer der grandiosen Hütten. Da sind wir wieder beim Schlafen!

Prof. Dr. Björn Ommer

Am liebsten sportliche Bewegung in der Natur unserer realen Welt.

Vielen Dank für das Gespräch!

Gebärdensprache

Gebärdensprache

Leichte Sprache

Leichte Sprache