Prof. Dr.-Ing. Thomas Wiegand

Digitalisierung ist die Darstellung von Signalen, in unserem Fall also der Videos, mittels Zahlen, die wir in einem Computer speichern und verarbeiten können. Erst dadurch können Computer und die damit verknüpften Vorteile ins Spiel kommen.

Dr.-Ing. Detlev Marpe

Das Problem bei der Digitalisierung ist, dass eine sehr große Menge an Daten anfällt. Ein HD-Bild, also ein hoch aufgelöstes Bild, hat in der Regel ungefähr 2,000 x 1.000 Bildpunkte. Damit generieren wir pro Bild ein Datenvolumen von circa 3 Megabyte. Wenn wir nun eine Sequenz von solchen HD-Bildern mit einer für Kinofilme typischen Bildwiederholrate von 24 Bildern pro Sekunde speichern wollen, fallen pro Sekunde über 70 Megabyte an Daten an. Damit wäre eine Blu-ray Disc mit einer Kapazität von 25 Gigabyte bereits nach einem sechsminütigen HD-Clip vollständig erschöpft. Das heißt also, dass wir etwas tun müssen, um digitalisierte Videos in wirtschaftlicher Form speichern oder übertragen zu können. Mit der Komprimierung kann man nun einen effizienten Abtausch zwischen der notwendigen Reduktion der aufzuwendenden Datenmenge und der Qualität des Videos erzielen.

Dr.-Ing. Heiko Schwarz

Sie müssen sich das so vorstellen: 600 Megabit pro Sekunde an Videorohdaten werden nun mit 10 Megabit pro Sekunde, also 1/60 der Rohdaten, gespeichert oder übertragen. Und das geschieht durch die Kompression.

Ihre Innovation gilt dem bewegten Bild. Dessen Anteil am gesamten Consumer Internet Traffic wird laut einer Prognose für 2012 auf circa 60 bis 70 Prozent geschätzt. Das ist ein erheblicher Bestandteil. Was passiert konkret bei der Videocodierung, und was war der Stand der Technik, bevor es Ihre Innovation gab?

Dr.-Ing. Heiko Schwarz

Bei der Videocodierung werden Abhängigkeiten zwischen einzelnen Bildern und innerhalb von Bildern ausgenutzt. Man kann bei Bildern viele Bereiche gut vorhersagen. Zum Beispiel können Bildinhalte, die sich nicht verändern, einfach kopiert werden. Tritt eine Bewegung von Bild zu Bild auf, kann diese kompensiert werden; es wird dann nur die Differenz zwischen dem tatsächlichem Signal und dem aus dem letzten Bild vorhergesagten Teil übertragen. Und darüber hinaus – wenn ein Bildinhalt nicht aus dem vorherigen Bild vorhergesagt werden kann, dann vielleicht aus einem Bild, das weiter zurückliegt.

Das sind die Grundprinzipien der Videocodierung in Bezug auf die statistischen Abhängigkeiten. Hinzu kommen die Möglichkeiten der Ausnutzung unterschiedlicher Häufigkeiten. Wenn ein Signal häufiger auftritt, kann man es mit weniger Bits und dann zwangsläufig die seltener auftretenden Signale mit mehr Bits übertragen. Das führt insgesamt zu einer verringerten Anzahl von Bits.

Schließlich entfernen wir bei der Videocodierung Signalanteile, die man nicht direkt wahrnimmt. Wenn man damit zu weit geht, kann das einerseits zu Störungen führen, die die Zuschauer als unangenehm empfinden. Andererseits kann durch die Vergrößerung der Störungen die Bitrate der Übertragung verringert werden. Ein sinnvoller Abtausch zwischen Bildstörungen und Bitrate ist enorm wichtig.

Dr.-Ing. Detlev Marpe

Die Videocodierung hat sich evolutionär entwickelt. Seit den 1970er-Jahren forscht man aktiv daran, und schon seit dem Ende der 1980er-Jahre wurde das Thema auch international standardisiert. Die grundlegenden Prinzipien der Videocodierung, die Heiko Schwarz erläutert hat, hatte man zu diesem Zeitpunkt schon erkannt und auch umgesetzt. Die Vorgängerstandards von H.264/AVC waren MPEG-2, MPEG-4 und H.263. Dabei war MPEG-2 der am weitesten verbreitete Standard für die damals wichtigen Anwendungen digitales TV und DVD. MPEG-4 und H.263 sind jüngeren Datums als MPEG-2, haben aber keine ausreichenden Verbesserungen gegenüber MPEG-2 für die Anwendungen digitales TV und DVD erzielen können. Dieser Aspekt und das Timing von H.263 und MPEG-4 haben bewirkt, dass diese MPEG-2 nicht verdrängen konnten, sondern es ergänzten für Anwendungen wie Videotelefonie oder das damals aufkommende Internet-Streaming. Somit waren diese Standards der Stand der Technik.

Für die moderne Videocodierung muss man natürlich alle Register ziehen, um eine möglichst hohe Effizienz zu erzielen. Ganz konkret bedeutete das für H.264/AVC, dass ein erheblicher Bitratengewinn gegenüber dem damaligen Stand der Technik, also MPEG-2, MPEG-4 und H.263, erreicht werden sollte. Das Ziel der Bitratenreduktion war ein Faktor zwei, das heißt das Erreichen der gleichen Qualität bei halber Bitrate. Und das war unser Beitrag: Wir haben Techniken erforscht, die die Effizienz der Codierung deutlich verbessert haben.

Wenn wir das jetzt mal für den Laien ganz reduziert darstellen, haben Sie eine Struktur entwickelt, die Bilddaten so komprimiert und formatiert, dass man sie auf die Datenautobahn schieben kann. Das klingt jetzt ganz einfach, was es sicher nicht war. Um das Prinzip als Prozess durchzusetzen, gehörte noch eine weitere Maßnahme hinzu?

Prof. Dr.-Ing. Thomas Wiegand

Dieser Strukturbildungsprozess erfordert einiges an Mathematik und Signalverarbeitung, und den endgültigen Ergebnissen sind sehr, sehr viele Berechnungen und Simulationen vorausgegangen. Um diese dann in die Welt zu tragen, haben wir uns an der internationalen Standardisierung beteiligt und unsere Innovationen dort eingebracht, um sie dann auch im weltweiten Wettbewerb voranzubringen.

Wir verstehen uns auch als Schnittstelle zwischen Wissenschaftlern und Ingenieuren. Wir rechnen viel, wir simulieren viel und bringen es in die Standardisierung ein, um es letzten Endes in Produkten zu verwerten. Aber wir publizieren auch sehr umfangreich. Das heißt, wir versuchen, diese Brücke zu schlagen von der Universität und dem Forschungsinstitut hin zur praktischen Umsetzung.

Das ist vielleicht einer der Gründe, warum wir für den Zukunftspreis nominiert sind. Die vier wichtigsten Innovationen, die wir geleistet haben, sind zunächst Verbesserungen von H.264/AVC selbst, dem Basiscodec – und dann die Entwicklung des jeweiligen Basismodells bei allen drei Erweiterungen. Da ist zunächst die erste Erweiterung von H.264/AVC für HD-Video, die auf unserem in die Standardisierung eingebrachten Basismodell beruht. Das ist heute in den meisten HDTV-Empfängern, allen Blu-ray-Geräten und in sehr vielen Internet- und Mobilfunk-Videoübertragungen enthalten. Bei der skalierbaren Videocodierung für Videotelefonie haben wir uns in einem Call gegen 13 andere Vorschläge durchgesetzt. Skalierbare Codierung ist heute Grundlage für Videokonferenzsysteme. Und bei der Codierung für 3-D-Videos haben wir uns gegen acht Konkurrenzvorschläge behauptet. Diese 3-D-Videocodierung ist heute ein Teil der 3-D-fähigen Blu-ray-Abspielgeräte.

Heißt das, dass auch das Endgerät – wir haben inzwischen Fernsehen, PC, Tablets – in Ihre Arbeit einbezogen werden?

Prof. Dr.-Ing. Thomas Wiegand

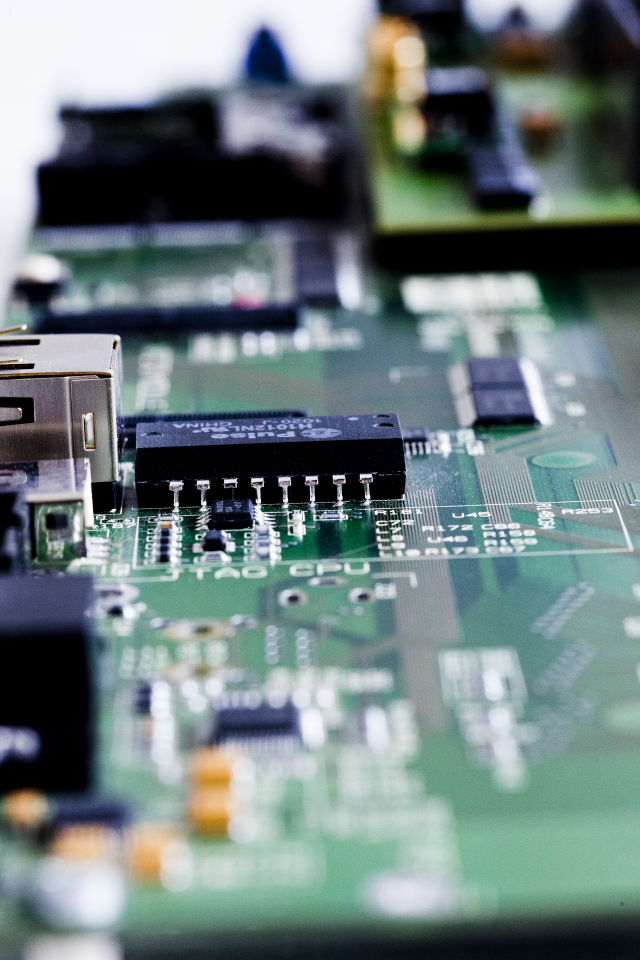

Ja, alle diese Endgeräte, die ich gerade erwähnt habe, und noch einige wichtige Kategorien mehr, wie Smartphones oder Tablets, denen wir täglich begegnen, enthalten unsere Innovationen. Wir arbeiten an beiden Seiten der Videoübertragung: Wir arbeiten am Sender, dem sogenannten Encodierer, der das Video in Bits verwandelt, und wir arbeiten am Empfänger, dem Decodierer, der die Bits in ein Video zurückverwandelt. Beide Teile zusammengenommen, also Encodierer und Decodierer, werden als Codec bezeichnet.

Und das unterscheidet sich dann eben nach den diversen Endgeräten?

Dr.-Ing. Heiko Schwarz

Der Standard spezifiziert das Format und wie am Decodierer das Format zurück ins Bild umgesetzt, also decodiert, wird. Hierbei gibt es verschiedene sogenannte Profile. Das sind Teilmengen von Tools, von Codierwerkzeugen, die auf bestimmte Anwendungen zugeschnitten sind. Wenn man eine bestimmte Anwendung hat, die auf einem relativ kleinen Gerät laufen soll, muss man Rücksicht auf die entsprechend eingeschränkten Leistungsmerkmale nehmen, die so ein Gerät bietet. Dann kann man nur eine Teilmenge an Werkzeugen verwenden. Ganz anders ist es, wenn man zum Beispiel eine Anwendung mit Set-Top-Boxen realisiert, da hat man ganz andere Möglichkeiten. Man kann aus einem reichhaltigeren Tool-Set, also im Prinzip einer Art Werkzeugkasten, die unterschiedlichen Profile zusammenstellen.

Kommen wir noch mal zum Prozess der Standardisierung. Wie ist der vonstatten gegangen?

Prof. Dr.-Ing. Thomas Wiegand

Im Standardisierungsprozess reichen die Teilnehmer Vorschläge ein, in denen sie ihre Ideen und Technologien beschreiben und die zugehörigen Resultate liefern. Die anderen Experten in der Standardisierungsgruppe unterziehen diese dann einer Prüfung. Das heißt, andere vollziehen den Vorschlag nach und verifizieren ihre Simulationsergebnisse. Dann wird anhand der Vor- und Nachteile des Vorschlags entschieden, ob dieser in den Standard aufgenommen wird oder nicht. Das bedeutet also: Wenn man einen Vorschlag macht und dieser übernommen wird, dann hat man letzten Endes eine Art Qualitätssiegel erhalten und zu diesem Thema eine bessere Lösung entwickelt als die anderen Teilnehmer.

Gibt es Parallelentwicklungen von anderen, die genauso gut sein könnten, oder sind Sie allein auf weiter Flur, und man sagt: „Schön, dass Sie sich die Mühe gemacht haben, und wir nehmen das als Standard“?

Prof. Dr.-Ing. Thomas Wiegand

Es gibt häufig konkurrierende Vorschläge, die andere Kennzahlen haben, die vielleicht mehr oder weniger effizient, mehr oder weniger komplex sind. Sich dann durchzusetzen, wie es uns bei den Erweiterungen von H.264/AVC gelungen ist, heißt auch, dass man in diesem Effizienz-Komplexitäts-Abtausch besser dasteht als andere Vorschläge. Darüber hinaus gibt es auch manchmal die Möglichkeit, Partnerschaften einzugehen, wenn Vorschläge ähnlich oder vereinbar sind. Für uns sind das Partnerschaften mit Industriefirmen zu dem Zweck, gemeinsam den Vorschlag auszuarbeiten und voranzubringen.

Stichwort Zeit: Wie lange dauert eine Bearbeitung, also der Standardisierungsprozess?

Dr.-Ing. Detlev Marpe

Die Entwicklung von H.264/AVC erstreckte sich über einen Zeitraum von zehn Jahren, vom ersten Testmodell bis zu der letzten Erweiterung für 3-D-Video, die wir 2008/2009 verabschiedet haben.

Es gibt verschiedene Phasen in der Standardisierung. Die erste Phase ist die, in der es einen offiziellen Aufruf, einen „Call“, gibt. Zu diesem Call werden dann verschiedene Vorschläge eingereicht, und die werden, wie Thomas Wiegand bereits sagte, einer Evaluierung unterzogen. Anschließend wird in der Regel aus einem der Vorschläge ein Testmodell erstellt, das ist dann die Grundversion des Standards. Von dieser Grundversion des Standards ausgehend wird dann weitergearbeitet. Das geschieht im Rahmen der zweiten, sogenannten „kollaborativen“ Phase, in der, ausgehend vom Testmodell, verschiedene darauf aufbauende Tools gemeinsam weiterentwickelt werden.

Sie sagen, dass dieser Prozess zehn Jahre gedauert hat – eine lange Zeit! Waren Sie sich immer sicher, dass Sie auf dem richtigen Weg sind?

Prof. Dr.-Ing. Thomas Wiegand

H.264/AVC hieß ursprünglich H.26L in der ITU, der Internationalen Telekommunikationsunion in Genf. Dass dieses Projekt etwas wird, war lange Zeit nicht klar. Es gab seit 1996 bereits, wie Detlev Marpe erwähnte, den MPEG-2-Standard, der die Basis für die DVD und das digitale Standardfernsehen ist. Dieser Standard war in seiner Ausbreitung sehr dominant. Es war auch nicht klar, ob man in Relation zu diesem Standard große Gewinne erzielen kann. Aber all das ist ja dann mit dem Entwicklungs- und Standardisierungsprozess von H.264/AVC geglückt. Wir haben schon zu einem sehr frühen Zeitpunkt in das Verfahren investiert, zum Beispiel die H.264/AVC-Referenzsoftware übernommen, die wir bis heute betreuen. Darüber hinaus habe ich mich als Editor des Standardisierungstextes freiwillig gemeldet. In Anbetracht des Erfolgs war das natürlich auch eine glückliche Investition.

Dr.-Ing. Detlev Marpe

Wie Thomas Wiegand schon sagte, war der Erfolg von H.264/AVC nicht von Anfang an sicher. Als wir anfingen, war das Projekt noch von der ITU aufgesetzt. Hier war das Ziel, einen Nachfolgestandard für ihren Videokonferenz- und Mobilfunk-Videocoder zu entwickeln. Da war noch nicht die Rede von High Definition oder von irgendwelchen anderen Anwendungen. Und dann hat sich das Projekt – man muss sagen, auch durch viele Zufälle, die sich dann im Laufe der Entwicklung ereignet haben – auch partiell, immer stückweise, in Richtungen entwickelt, die immer mehr Anwendungen erschlossen haben.

Voraussetzung für eine Standardisierung ist, dass diese Technologie zu fairen Bedingungen hinterher lizenziert wird. Was versteht man unter „fairen Bedingungen“?

Prof. Dr.-Ing. Thomas Wiegand

Der Standard enthält Patente, die die Innovationen schützen. Diese Patente werden im Rahmen eines Lizenzierungsprogramms zur Verfügung gestellt. Derzeit gibt es ungefähr 1.200 Firmen, die H.264/AVC für ihre Produkte lizenziert haben. Die Lizenzbedingungen sind für alle Firmen gleich und somit nicht diskriminierend. Wenn die Firmen die Lizenz erwerben und die Stückzahl relevant ist, kostet ein Decoder 10 US-Cent, was von der Höhe her ein fairer Lizenzpreis ist. Mit der Lizenz haben die Lizenznehmer das Recht von den Patentinhabern erworben, den Codec zu verwenden. Und das bietet eine gewisse Rechtssicherheit.

Die andere Frage ist, wie man Produkte daraus entwickelt. In zahlreichen Partnerschaften mit der Industrie haben wir an den wissenschaftlichen und technischen Innovationen, die wir zur Standardisierung gebracht haben, weitergearbeitet und diese zu Produkten entwickelt.

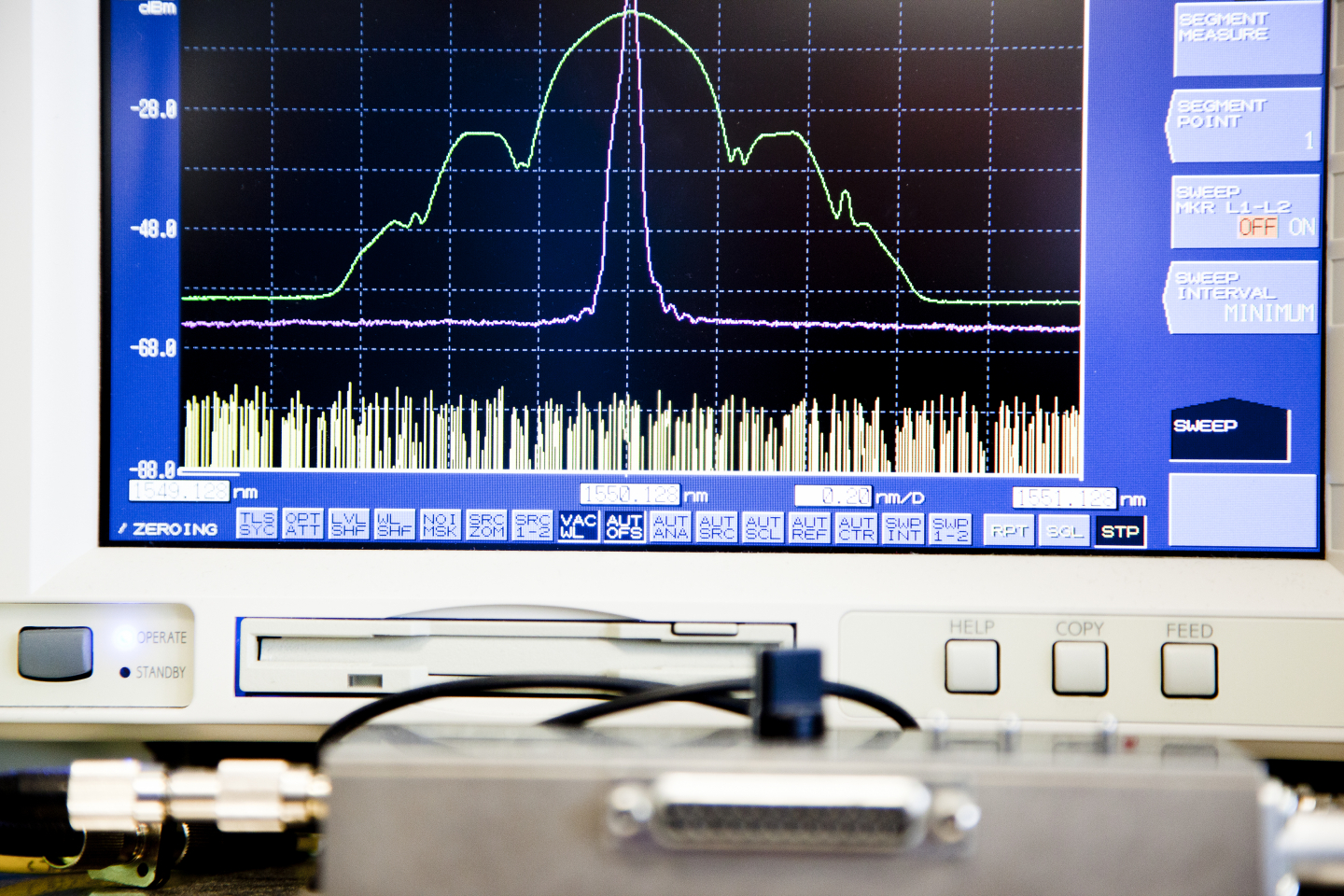

Wir haben mit der Firma Thomson an einem Encoding-Projekt gearbeitet, um deren Übertragungstechnik zu verbessern. Mit Siemens und Bosch waren wir in Projekten zusammen. Zum Teil haben wir eigene Produktentwicklungen durchgeführt, etwa in einer Partnerschaft mit Rohde & Schwarz, die unseren Codec als Implementierung lizenziert haben. Wir haben die Software zur Verfügung gestellt und an Rohde & Schwarz lizenziert. Die entsprechende Hardware wurde dann an Kunden weltweit zusammen mit weiteren Geräten des Unternehmens verkauft.

Ist der Standard nur für bestimmte Anwendungen vorgesehen?

Dr.-Ing. Heiko Schwarz

Nein, der Standard ist zunächst universell einsetzbar. H.264/AVC kann man sowohl für medizinische Anwendungen – zum Beispiel in der Telemedizin, einem sehr großen Innovationsfeld mit hoher Kostenrelevanz – als auch für Videokonferenzen nutzen. Gerade im letzteren Fall spielt der Umweltgedanke eine Rolle, wenn Geschäftspartner, anstatt zu fliegen, per Videokonferenz Treffen abhalten. Hinzu kommen natürlich der riesige Bereich von Anwendungen über das Internet und den Mobilfunk sowie Klassiker wie das TV, was sich zusehends in Richtung HD- und 3-D-TV entwickelt.

In oder mit welchen Produkten wird der Standard genutzt? Wir haben schon von HDTV, von Blu-ray und von Videokonferenzen gesprochen – was gibt es noch?

Dr.-Ing. Detlev Marpe

Der Standard findet sich überall im weiten Feld der Konsumelektronik, also in Fernsehgeräten, in Set-Top-Boxen, Blu-ray-Playern, digitalen Kameras und Camcordern. Daneben haben wir die klassischen PCs. Ich denke, dass man heutzutage auf fast jedem PC H.264/AVC in irgendeiner Form wiederfindet, zum Beispiel als Bestandteil oder Plug-in eines jeden Webbrowsers. Dann sind da noch die mobilen Endgeräte, also Smartphones und Tablets, und die verschiedenen Bereiche, die Heiko Schwarz schon angesprochen hat: Videoplattformen im Internet, Videokommunikation, Telemedizin, videobasierte Sicherheitstechnik, und nicht zuletzt befindet sich H.264/AVC auch auf dem Weg in die Automobiltechnik.

Prof. Dr.-Ing. Thomas Wiegand

In der Medizintechnik ist es schon sehr präsent. Telemedizin hat ein großes Potenzial für Kostenersparnisse in der Medizin. Wenn man ein Krankenhausbett nicht belegen muss, weil beispielsweise der Patient per Telemedizin betreut werden kann, spart man eine Menge Geld. Hinzu kommt, dass es sicherlich auch für die Patienten angenehmer ist, im häuslichen Umfeld bleiben zu können.

Auch die Videoverteilung im Fahrzeug von Kameras, die im Fahrzeug angebracht sind, und von Multimedia-Geräten ist ein Thema, das jetzt gerade mit H.264/AVC in Bewegung kommt; daran arbeiten wir konkret mit Industriepartnern.

Gibt es Wettbewerb, oder ist dies, sobald der Codec standardisiert ist, nicht mehr relevant?

Dr.-Ing. Detlev Marpe

Es gibt durchaus Wettbewerb. Als H.264/AVC fertig gestellt wurde, kam beispielsweise Microsoft mit einem Videocodec, VC1 genannt, heraus. Es war zunächst nicht ganz klar, ob sich diese geschlossene, proprietäre Entwicklung durchsetzen würde oder der offene Standard. Am Ende hat sich der offene Standard klar durchgesetzt. Mittlerweile ist die Verbreitung von H.264/AVC so groß, dass es da wohl keine Zweifel mehr gibt: Wir schätzen, dass es ungefähr 700 Millionen H.264/AVC-fähige Konsumelektronikprodukte gibt, also Fernsehgeräte oder Set-Top-Boxen. Wir haben circa eine Milliarde PCs und ungefähr 1,3 Milliarden mobile Endgeräte wie Tablets und Smartphones, die H.264/AVC in der einen oder anderen Form enthalten. Das heißt, wir stehen jetzt bei rund 3 Milliarden Realisierungen weltweit. Dann gibt es noch die Blu-ray Discs: Davon sind mittlerweile 1,4 Milliarden Stück, also rund 70 Prozent aller weltweit verkauften Scheiben, mit H.264/AVC codiert worden.

Prof. Dr.-Ing. Thomas Wiegand

Eine andere interessante Kenngröße für die Verbreitung von H.264/AVC: Wenn man Video als Datenaufkommen im Internet betrachtet, so könnte man IP-TV, Video on Demand, auch Peer-to-peer-Filesharing – das enthält ja viel Video –, Videoconferencing und Internetvideo zusammenrechnen und kommt laut einer Studie von Cisco auf etwa 70 Prozent aller Bits im Consumer-Internet. Das bedeutet, dass bei der überwältigenden Nutzung von H.264/AVC auch in diesem Bereich, ein großer Anteil der Bits im Internet mit dem Standard codiert ist.

Die Standardisierung ist eine Stufe, ein Status, daran wird weiterentwickelt. Fühlt man sich dabei als Gejagter, oder ist es ein Ansporn zu sagen: Jetzt will ich noch eine Stufe weiterkommen? Hat man den Standard im Genick?

Prof. Dr.-Ing. Thomas Wiegand

Der Standard ist durchaus ein Ansporn weiterzumachen. Die Rückflüsse, die wir aus unseren Entwicklungen bekamen, haben wir dazu genutzt, neue Forschung aufzusetzen. Gegenwärtig befindet sich ein neuer Standard in der Entwicklung: High Efficiency Video Coding – HEVC. Dieser Standard hat bereits zwei Entwicklungsstufen durchlaufen: Zunächst gab es einen Call, einen Aufruf für Beiträge zu diesem Basisstandard. An dem haben wir teilgenommen, dabei sehr gut abgeschnitten und zusammen mit Industriefirmen das erste Testmodell gestellt. Das war der Teil zum Basisstandard. Dann gab es einen weiteren Aufruf zur Einreichung von Beiträgen für die 3D-Erweiterung von HEVC. Da ging es nicht nur um Stereo – also 3D mit einer Stereo-Brille –, sondern um autostereoskopische Displays, also 3D ohne Stereo-Brille.

Dr.-Ing. Heiko Schwarz

Diesen Aufruf zur 3D-Erweiterung von HEVC haben wir gewonnen. Es war hier auch wieder so, dass unser Vorschlag als Basismodell gewählt wurde. Das war im Dezember 2011. Bis heute ist der Vorschlag, bis auf ein paar kleinere Elemente, immer noch so, wie wir ihn eingereicht haben. Wir haben dann die Spezifikation geliefert, die Software, und die ist dann von der Standardisierungsorganisation als Startpunkt für das Projekt genutzt worden – so wie zuvor bei Stereo oder bei der skalierbaren Codierung für H.264/AVC. Und darauf aufbauend wird jetzt weitergearbeitet.

Hinzu kommt, dass wir natürlich auch an der kollaborativen Phase der Standardisierung teilnehmen. Zum einen wollen wir kontinuierlich nachweisen, dass die Originalideen, die wir eingebracht haben, leistungsfähig sind. Zum anderen können wir deren Leistungsfähigkeit weiter verbessern.

Prof. Dr.-Ing. Thomas Wiegand

Wir befinden uns eigentlich in einer traumhaften Lage: Wir können wissenschaftlich arbeiten und haben eine Möglichkeit, die Technologie, die wir aus den wissenschaftlichen Grundlagen heraus erarbeiten, so einzubringen, dass sie am Ende vielleicht überall eingesetzt wird. Bei H.264/AVC ist uns das gelungen, beim neuen Standard HEVC sind wir dabei, es erneut zu versuchen.

Wie haben Sie sich eigentlich als Team gefunden? Durch das Projekt?

Dr.-Ing. Detlev Marpe

Gewissermaßen ja: Ich habe Thomas Wiegand auf einem Standardisierungstreffen 1999 in Berlin kennengelernt.

Prof. Dr.-Ing. Thomas Wiegand

Genau, das erste Testmodell von H26L wurde bei diesem Treffen im August 1999 festgelegt. Und zu dem Treffen war ich nach Berlin gekommen – ich war am Ende meiner Dissertation in Erlangen – da wurde H264 geboren! Ich habe dann gleich das HHI besucht und Detlev Marpe kennengelernt. Später traf ich ihn auf einem Standardisierungstreffen in New Jersey wieder. Eigentlich war ich auf dem Weg zu einer anderen Stelle; man hatte mir eine Assistenzprofessur an der Universität Kalifornien in Los Angeles angeboten. Das habe ich Detlev Marpe erzählt, der es seinem Abteilungsleiter, Dr. Schäfer am HHI, erzählte. Auf einmal bekam ich eine E-Mail von Herrn Schäfer, der sagte, dass eine Stelle hier frei werden würde, die auf mich passen könnte, und ob ich nicht Interesse hätte.

Dr.-Ing. Heiko Schwarz

Ich bin im Jahr 2000/2001 an das HHI gekommen. Es war auch eigentlich mehr ein Zufall, denn als ich mit der Dissertation in Rostock fertig war und nach einem Job suchte, hat mich meine Professorin, die mich damals in Rostock betreut hat, Herrn Dr. Schäfer, den sie von Veranstaltungen und Fachtagungen kannte, empfohlen. Herr Schäfer hat damals Mitarbeiter gesucht. Und so bin ich hierher gekommen und habe Thomas Wiegand und Detlev Marpe kennengelernt.

Prof. Dr.-Ing. Thomas Wiegand

Herr Schäfer, der viele Jahre diese Abteilung geleitet hat – jetzt leiten wir sie gemeinsam – hat uns zusammengebracht und uns immer massiv gefördert. Er hat einen großen Anteil an unserem Erfolg.

Wie viele Leute waren über die Zeit oder sind derzeit im Team mit dem Thema beschäftigt?

Prof. Dr.-Ing. Thomas Wiegand

Wir fingen sehr klein an: die drei, die vor Ihnen sitzen. Dann gab es noch zwei weitere Kollegen, die mitwirkten, aber recht früh das HHI verlassen haben. Aber seit 2006 haben wir sukzessive immer mehr Leute hinzugewonnen. Mittlerweile ist das Team auf 20 Mitarbeiter angewachsen.

Eine Bedingung für eine Nominierung zum Deutschen Zukunftspreis ist, dass mit dem Projekt langfristig Arbeitsplätze geschaffen werden. Wie sieht das bei Ihrer Innovation damit aus?

Prof. Dr.-Ing. Thomas Wiegand

H.264/AVC wird in so vielen Produkten und Diensten hier in Deutschland eingesetzt, dass dies schwer zu quantifizieren ist. Der Standard ist, wie viele Kompressionstechniken, eine Technologie, die etwas ermöglichen soll. Wenn es H.264/AVC nicht gäbe, könnte man bestimmte Produkte nicht anbieten. Ein Beispiel ist das IP-TV der Deutschen Telekom. Wenn man eine DSL-Leitung hat, kann man vielleicht 16 MBit pro Sekunde darüber übertragen. Wenn man jetzt HDTV ausstrahlen will – was man heute bei einem konkurrenzfähigen Produkt anbieten muss –, würde das ohne bessere Kompression wie bei H.264/AVC eigentlich nicht gehen. Das heißt, das Produkt der Telekom ist durch bessere Codierung erst möglich gemacht worden, und HDTV selbst ist durch H.264/AVC und dessen massenhafte Verbreitung erst wirtschaftlich umsetzbar geworden. Und die Innovationen, die damit verbunden sind, die Übertragungstechnik, die neuen Set-Top-Boxen, die neuen Displays – all das ist die Konsequenz daraus, dass es den Standard gibt.

Dr.-Ing. Detlev Marpe

Das Spektrum der Industrieunternehmen in Deutschland, die H.264/AVC-relevante Produkte fertigen, reicht von Herstellern von HD-Receivern und HD-Fernsehgeräten über Produzenten von Videoüberwachungssystemen bis hin zu weltweit führenden Anlagenherstellern und Fertigungsbetrieben für die Produktion von Blu-ray Discs. Das impliziert natürlich auch Arbeitsplätze. Und vergessen dürfen wir in diesem Zusammenhang auch nicht die Filmindustrie als weiteren Nutznießer des Standards, gerade hier in der Filmstadt Berlin.

Interessant ist auch der Aspekt, dass mit H.264/AVC in den vergangenen Jahren zum Teil vollkommen neuartige Anwendungen entstanden sind, zum Beispiel Video-Podcasts in Mediatheken oder Video-Chats in sozialen Netzwerken. Dabei lassen sich die wirtschaftlichen und gesellschaftlichen Auswirkungen, die mit diesen neuen Anwendungen verbunden sind, noch gar nicht richtig abschätzen.

Lassen Sie uns bitte nochmals zusammenfassen, was das Innovative an Ihrem Projekt ist, das jetzt mit der Nominierung zum Deutschen Zukunftspreis gewürdigt wird.

Prof. Dr.-Ing. Thomas Wiegand

Wir haben im Wesentlichen vier Beiträge geleistet. Der erste Beitrag sind Verbesserungen von H.264/AVC, dem Basisstandard selbst. Dazu gehört die arithmetische Codierung, um mal einen Fachbegriff zu benennen, bei der am Ende des Encodierers die Bits produziert werden, die übertragen werden. Zudem haben wir bei der zeitlichen Vorhersage wesentlich mitgewirkt und auch Methoden der Encodersteuerung eingebracht, die wesentlich dazu beigetragen haben, dass man den Weg, den man mit H.264/AVC gehen wollte, technologisch einschlagen konnte.

Die zweite Innovation ist die, dass es einer Verbesserung des Basisstandards bedurfte, um HDTV effizient zu realisieren. Dafür haben wir das erste Modell vorgeschlagen, auf das dann aufgebaut wurde und das am Ende in jenen Teil von H.264/AVC mündete, der heute in fast jedem HDTV-Empfänger vorhanden ist. Auch alle Blu-ray-Player enthalten das Ergebnis dieser Erweiterung von H.264/AVC. Weiterhin steigt die Anzahl mobiler Endgeräte stetig, die diese Erweiterung enthalten.

Drittens haben wir in einem Call für skalierbare Videocodierung erfolgreich das erste Modell gestellt und uns dabei gegen 13 andere Teilnehmer durchgesetzt. Dazu haben wir neue Algorithmen für die skalierbare Videocodierung erforscht, die die Effizienz stark erhöhten. Und weil wir diese neuen, effizienten Methoden eingebracht haben, konnten wir uns auch durchsetzen. Die skalierbare Erweiterung von H.264/AVC wird zum Beispiel sehr umfangreich in Anwendungen in der Videokommunikation verwendet. Damit sind Videokonferenzen in HD über das Internet mit einer Vielzahl unterschiedlicher Endgeräte möglich geworden.

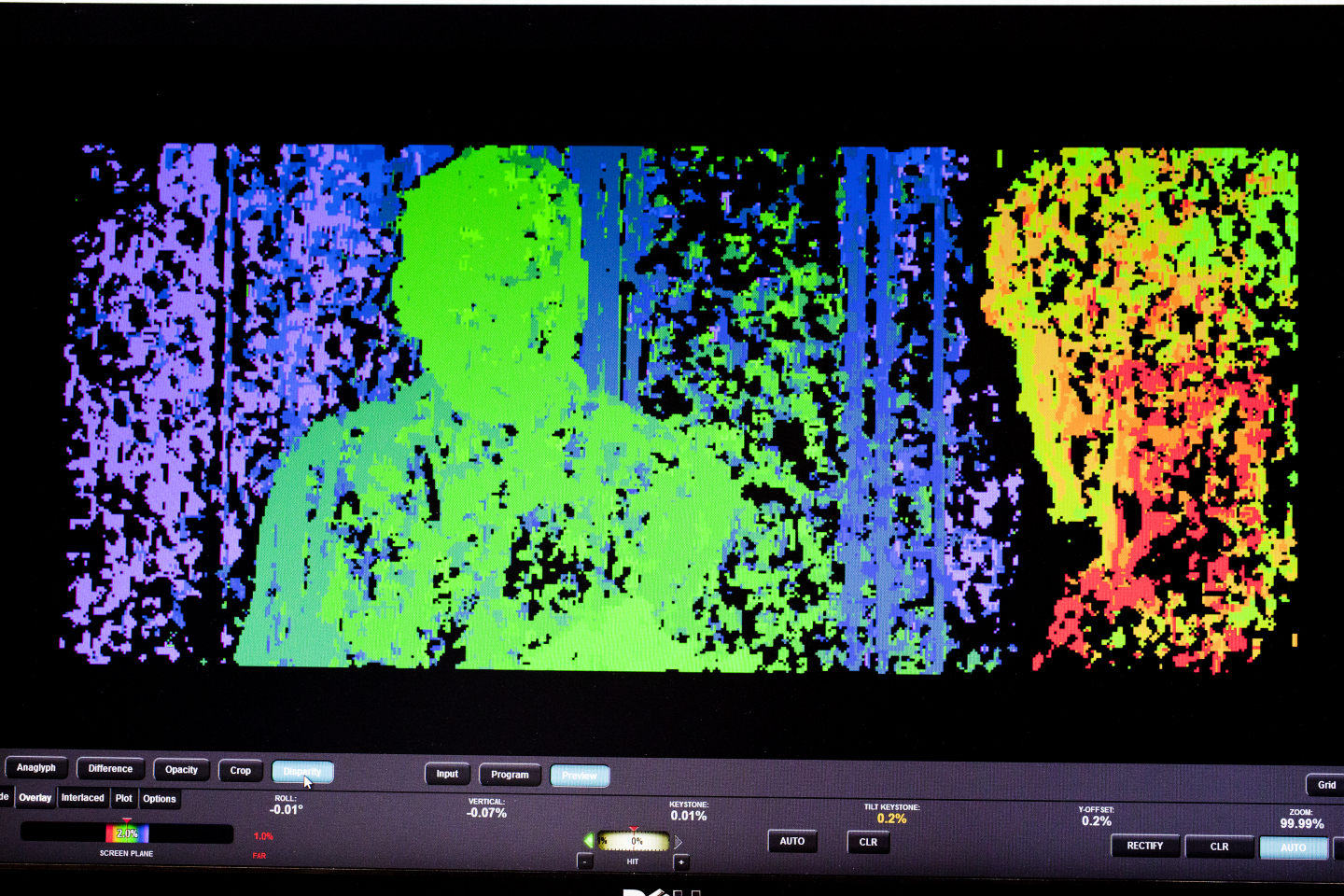

Bei 3-D-TV schließlich, der vierten Innovation, haben wir uns gegen acht andere Wettbewerber mit einem Konzept durchgesetzt, mit dem wir die Stereo-Videocodierung so angelegt haben, dass diese sehr, sehr schnell in Endgeräte Einzug halten konnte. Dabei war es uns wichtig, dieses Konzept einfach zu halten, sodass vorhandene H.264/AVC-Decodierchips ganz leicht wiederverwendet werden können. Diese 3-D-Erweiterung von H.264/AVC ist jetzt in jedem 3-D-fähigen Blu-ray-Abspielgerät verbaut.

Unser Projekt besteht also aus mehreren Innovationen, die jede für sich Auswirkungen auf unser Leben hat.

Kommen wir zu Ihrem persönlichen Weg: Sie haben Elektrotechnik, Mathematik oder Physik studiert. Wie sind Sie zu dieser Entscheidung gekommen, oder was wollten Sie als Kind werden?

Dr.-Ing. Heiko Schwarz

Wahrscheinlich jede Woche etwas anderes … Bereits in der Schule haben mich Mathematik und Naturwissenschaft im Allgemeinen sehr interessiert. Das wurde bei mir damals stark gefördert. Ich war in einer Spezialschule für Mathematik und Naturwissenschaften. Dann habe ich mit dem Elektrotechnik-Studium begonnen, ohne mir allzu große Gedanken darüber zu machen – wahrscheinlich hätte mich Physik sogar noch mehr interessiert. Aber die Überlegung, wo man später einen Job findet, hat ich mich zur Elektrotechnik gebracht. Ich habe dann später auch auf dem Fachgebiet promoviert bevor ich dann hier ans HHI gegangen bin.

Prof. Dr.-Ing. Thomas Wiegand

Ich bin in Wismar an der Ostsee groß geworden und hatte meine Stärken als Schüler ebenfalls in Mathematik und Naturwissenschaften. Aber als ich auf das Gymnasium wollte, wurde mir gesagt, dass ich, bevor ich studieren könne, drei Jahre zur NVA müsse. Das wollte ich nicht, und ich sah meinen Vater, der sehr glücklich wirkte, und der war Elektromonteur. Da habe ich nach zehn Klassen die Schule beendet, Elektromonteur gelernt, mir aber während der Ausbildung meinen Arm gebrochen, sodass ich dann auf einmal doch anfangen konnte zu studieren, weil ich von der NVA zurückgestellt wurde. 1988 habe ich damit angefangen, das Abitur nachzuholen.

Das Studium begann 1989, was, wie man sich ja vorstellen kann, eine Menge neuer Aspekte beinhaltete. Wir haben studentische Vertretungen gegründet, und ich war Mitglied des Studentenrats der Technischen Hochschule in Wismar. Wir haben Demos organisiert, und ich war auf dem besten Weg, Politiker zu werden, hatte aber irgendwo das Gefühl, dass das doch nicht das Richtige für mich ist.

Ich habe dann an der TU Hamburg-Harburg an meinem Hauptdiplom weiterstudiert mit der Spezialisierung Mess-, Steuer- und Regelungstechnik und an Themen wie Schadstoffmessungen oder Ähnlichem gearbeitet. Irgendwann – 1992, da war ich 22 Jahre alt – saß ich dort mit Kommilitonen in einer KneipeDer eine sagte, er werde das nächste Semester in Schottland verbringen, der nächste sagte, "ich gehe nach Kanada", und damals wollte ich eins draufsetzen im jugendlichen Überschwang und erzählte, dass ich nach Japan gehen will – ohne einen Plan zu haben. Dann habe ich meinen Mess-, Steuer- und Regelungstechnik-Professor gefragt, ob er jemanden in Japan kennen würde. Nein – aber er kannte einen Professor aus der digitalen Signalverarbeitung an der TU Hamburg-Harburg, der wiederum jemanden in Kobe in Japan kannte. Und so bin ich zu diesem Thema gekommen.

Ich war dann in Japan, das lief sehr gut, habe dann meine Diplomarbeit an der TU Hamburg-Harburg fertiggestellt und bin anschließend nach Kalifornien gegangen, an die Universität von Kalifornien in Santa Barbara. Dort habe ich jemanden getroffen, der ganz konkret das Thema Videocodierung bearbeitet hatte. Das war für mich der Anlass hier einzusteigen. Daraufhin hatte ich ein Thema in meiner Dissertation in Erlangen begonnen, das zum einen richtungweisend war, weil es auf die Ausnutzung steigender Speicherkapazitäten in der Videocodierung hinauslief – ein Aspekt, der zuvor vernachlässigt wurde. Zum anderen zeigte sich auch, dass das Ganze anwendbar war. So kam ich zur Standardisierung. Das erste Treffen, an dem ich – ein blutjunger Doktorand im ersten Monat – teilnahm, fand 1995 in Darmstadt statt. Zwischendurch war ich noch als Austauschstudent an der Stanford Universität und als Berater im Silicon Valley tätig. Nach der Dissertation kam dann der Punkt in meinem Leben, an dem ich entweder als Assistant Professor in die USA an die an die Universität von Kalifornien in Los Angeles gehen konnte und die Standardisierung hinter mir lassen musste oder ans HHI gehen und weitermachen könnte. Für Letzteres habe ich mich dann entschieden.

Dr.-Ing. Detlev Marpe

Mein beruflicher Lebensweg ist vielleicht nicht ganz so geradlinig verlaufen. Ich hatte verschiedene Optionen, und es gab verschiedene Richtungswechsel. Es begann mit Mathematik, und im Laufe meines Studiums stellte ich fest, dass mich die Anwendungen der Mathematik mehr reizen, woraufhin ich den Schwerpunkt meines Studiums immer weiter auf das Nebenfach Physik verlagert habe. Irgendwann musste ich mich entscheiden, den Abschluss in Physik oder den in Mathematik zu machen. Ich hatte zu der Zeit auch – mehr als Hobby – angefangen, mich mit Programmierung zu beschäftigen. Das war Anfang/Mitte der 1980er-Jahre, es gab die ersten PCs auf dem Markt. Dann habe ich mir einen PC zugelegt und begonnen, Verfahren der Numerik – mathematische Algorithmen – zu programmieren. Dabei lernte ich Leute kennen, die gerade dabei waren, einen Fachverlag für numerische Software zu gründen. Circa zwei bis drei Jahre habe ich daraufhin an der Entwicklung dieser Software mitgearbeitet – und mein Studium vernachlässigt. Das Produkt war damals, zumindest in Deutschland, einzigartig, gewissermaßen das erste Softwareprodukt mit einer Datenbank von typischen numerischen Algorithmen, die man als Ingenieur braucht. Das wurde dann aber leider ein Verkaufs-Flop. Daraufhin habe mich wieder zurückorientiert an die Uni, meinen Abschluss gemacht und mich in ein Promotionsprojekt gestürzt, das sich sehr intensiv mit Problemen der mathematischen Physik auseinandersetzte.

Das hatte zunächst überhaupt nichts mit Bildverarbeitung zu tun. Aber dann kam der Zufall ins Spiel: Ende der 1980er-/Anfang der 1990er-Jahre war eine neue Technologie in der Mathematik entwickelt worden, die auch ein großes Potenzial im Hinblick auf die Bildcodierung aufwies. Einige Professoren am Mathematischen Institut der TU Berlin riefen daraufhin ein Projekt ins Leben, um dieses Verfahren für die Bildverarbeitung nutzbar zu machen. Sie haben für dieses Projekt Leute gesucht, die neben dem mathematischen Verständnis auch in der Lage waren zu programmieren, also die Software-Seite einzubringen – und da war ich der richtige Mann. Über die Mitarbeit in einer Reihe weiterer Forschungsprojekte, die sich inhaltlich zunehmend auf die Videocodierung und Videoübertragung ausrichteten, kam ich dann schließlich 1998 ans HHI.

Was macht dieses Arbeitsgebiet spannend, und warum sollte man sich möglicherweise dafür entscheiden?

Prof. Dr.-Ing. Thomas Wiegand

Das aus meiner Sicht Spannende ist, dass wir das ganze Spektrum von Grundlagenforschung im Bereich Informationstechnik bis hin zur Umsetzung bearbeiten können. Bei uns können sich die Leute auf jedem dieser einzelnen Gebiete betätigen oder auch alles machen. Das ist natürlich eine ganz seltene Möglichkeit. Hinzu kommt, dass wir mit unseren Arbeiten weltweit Wirkungen erzielen können. Es ist ein schönes Gefühl zu wissen, dass unsere Forschungsergebnisse von vielen Millionen Menschen genutzt werden. Außerdem finden die mehrtätigen Standardisierungstreffen meistens auf einem anderen Kontinent statt. Das bietet hervorragende Chancen zum Aufbau eines internationalen Netzwerks und von Freundschaften. Und nicht zuletzt bietet sich nach wie vor eine große Anzahl spannender Fragestellungen auf unserem Forschungsgebiet.

Haben Sie genügend Mitarbeiter, oder gibt es da Probleme?

Prof. Dr.-Ing. Thomas Wiegand

Das ist unterschiedlich und entspricht eher dem „Schweinezyklus“. Immer, wenn die Wirtschaft gut läuft, haben wir Probleme, Leute zu bekommen. An der Universität oder hier im Institut sind wir an die Tarifordnung des öffentlichen Dienstes gebunden. Wenn man das Gehalt benennt, gehen manche eher in die Industrie. Attraktiv wird das eigentlich nur in Kombination mit einer Gelegenheit zur Promotion.

Von außen betrachtet stellt sich Ihre Innovation als ein konsequenter hochtechnologischer Prozess dar, Entwicklungsschritt auf Entwicklungsschritt. Ist in einem derart mathematischen und technologischen Prozess eigentlich so etwas wie Kreativität gefragt?

Prof. Dr.-Ing. Thomas Wiegand

Kreativität ist die Basis des Prozesses. Ohne gute Ideen kann man im Grunde genommen nur die Dinge nachbauen, die bereits andere gebaut haben. Damit ist man in einem Prozess wie der Standardisierung natürlich nicht erfolgreich, weil man davon ausgehen muss, dass alle anderen ihren eigenen Vorschlag mindestens mit Methoden des „State of the Art“ versehen haben.

Kreativität, Ideen generieren – das ist der Teil, der mich an diesem Prozess am meisten reizt. Ich habe eine Idee, und dann fängt es mit der Frage an, ob es funktioniert oder nicht. Viele der ersten Simulationen liefern oft nicht so gute Ergebnisse. Aber da muss man dranbleiben und hartnäckig weiterforschen. Und irgendwann – unter Umständen nach Jahren – klappt es dann vielleicht mit den Verbesserungen, und man geht die nächsten Schritte, um das Erforschte so umzusetzen, dass es im Standard landen könnte. Und wenn alles geklappt hat, findet sich die Idee weitere fünf Jahre später in so vielen Geräten wieder. Und das alles hat mit einer kreativen Idee begonnen – das ist, glaube ich, das Schönste an dem Ganzen: dass man seine Ideen umsetzen kann, und das mit einer solchen Wirkung.

Glück oder Zufall – spielt so etwas eine Rolle bei einem solchen Prozess?

Dr.-Ing. Heiko Schwarz

Es ist natürlich erst einmal harte Arbeit. Aber man braucht auch Glück, dass man die Arbeit zum richtigen Zeitpunkt macht und die Umstände so sind, dass das Ergebnis der Arbeit sich auch durchsetzen kann. So ist zum Beispiel die Umstellung auf digitales Fernsehen und HDTV mit der Verabschiedung von H.264/AVC zusammengefallen, was ein glücklicher Zufall war, sodass H.264/AVC in diesem Bereich wirklich erfolgreich werden konnte. Ohne diese zeitliche Komponente wäre es zumindest in diesem Bereich wahrscheinlich etwas anders gelaufen.

Dr.-Ing. Detlev Marpe

Es gibt noch einen anderen Faktor: Man muss manchmal einfach den Mut aufbringen, Dinge gegen den Strich zu denken. Als wir angefangen hatten, das erste Modell für H.264/AVC zu entwickeln, gab es in der Videocodierung ein ungeschriebenes Gesetz: Man verwendet keine arithmetische Codierung, weil sie zu komplex ist und nicht umgesetzt werden kann und somit in der Praxis im Vergleich zu den herkömmlichen Verfahren nichts bringt. Das war jedenfalls die generelle Auffassung, aber damit haben wir uns nicht zufrieden gegeben. Wir wollten genauer untersuchen, genauer wissen, ob es wirklich so ist. Und wir haben festgestellt: Wenn man es auf eine bestimmte Art und Weise macht, dann bringt es doch etwas! Man darf sich da nicht vom Mainstream beirren lassen.

Prof. Dr.-Ing. Thomas Wiegand

Das hat sich vor Kurzem erneut bestätigt: Als wir mit arithmetischer Codierung anfingen, waren wir vollständig gegen die allgemeine Meinung unterwegs. Der neue HEVC-Standard, an dem wir gerade arbeiten, enthält nur noch arithmetische Codierung. Das heißt, alle alten Methoden sind überholt, und man ist gewissermaßen zu einer nächsthöheren Entwicklungsstufe gekommen. Ein anderes Beispiel: Ich habe in meiner Dissertation untersucht, wie man Bewegungskompensation mit höherer Effizienz unter Inkaufnahme von mehr Speicherbedarf durchführen kann. Für ein Buch, das aus meiner Dissertation entstanden ist, habe ich von Gary J. Sullivan, einem der Leiter der Standardisierungsgremien, ein sehr schönes Vorwort bekommen, sinngemäß so: „Am Anfang der Arbeiten erschien es verschwenderisch, diesen Speicher zu benutzen. Heute erscheint es verschwenderisch, diesen Speicher nicht zu benutzen.“

Und dann gibt es noch ein weiteres Beispiel: die skalierbare Videocodierung. Das ganze Standardisierungsprojekt entstand eigentlich aus einem anderen technologischen Ansatz. Es ging auf eine lange Untersuchung zurück, die in der MPEG-Standardisierungsgruppe stattfand und bei der die Videocodierung auf eine komplett andere Basis gestellt werden sollte. Und wir verfolgten einen anderen Ansatz als die meisten und mussten uns mit unserer Idee gegen die Mehrheit durchsetzen. Dieser Prozess war teilweise sehr hart. Es gab mehrere Tests, die unabhängig durchgeführt wurden. Dabei waren wir immer vorne dran. Aber es gab eben dadurch, dass die Mehrheit der Experten dort eine andere Technologie bevorzugte, viele Diskussionen. Wir haben im Grunde drei Tests erfolgreich bestehen müssen, um die gängige Meinung zu verändern.

Sie sind ja auch schon ausgezeichnet worden für Ihre Arbeit. Ist so etwas hilfreich?

Prof. Dr.-Ing. Thomas Wiegand

Auszeichnungen sind eine hervorragende Anerkennung der Arbeiten und spornen zugleich an.

Was motiviert Sie, und was macht Sie ärgerlich?

Dr.-Ing. Detlev Marpe

Die Herausforderung, neue Wege zu finden, neue Ideen zu entwickeln. Und dann eben auch die Möglichkeit, diese Ideen einzubringen in einen Prozess, der letztlich in Produkte einmündet.

Ärgerlich machen mich Vorurteile, auch bestimmte Formen der Oberflächlichkeit: Ein ganz wichtiger Aspekt unserer Arbeit ist, dass wir mit sehr viel Akribie und sehr viel Fleiß an die Aufgaben herangehen und versuchen, die Dinge bis ins letzte Detail zu ergründen. Das macht auch einen guten Teil unseres Erfolges aus: dass wir nicht aufgeben, versuchen, wirklich 100 Prozent zu geben. Das ist auch notwendig, wenn man sich in diesem globalen Maßstab, in diesen Standardisierungsgremien, durchsetzen will.

Dr.-Ing. Heiko Schwarz

Mich motiviert es, Dinge zu verstehen. Dass ich nicht irgendwo lese, der hat das gesagt, dann ist das so, sondern dass ich die Zusammenhänge für mich selbst verstehe, so gründlich wie möglich. Und daraus dann auch neue, eigene Ideen ableiten und sie umsetzen kann. Schön ist es dann, wenn sich eine Idee durch Experiment verifizieren lässt und man Verbesserungen damit erzielt. Wenn nicht, hat man trotzdem meistens Erkenntnisse dazugewonnen.

Was macht mich ärgerlich? Eigentlich ärgert mich nicht allzu viel.

Prof. Dr.-Ing. Thomas Wiegand

Mich motiviert auch diese Möglichkeit, einen kreativen Prozess immer weiter zu treiben. Das ist auch der Aspekt, den Detlev Marpe angesprochen hat: dass es uns auszeichnet, eine verrückte Idee bis zum wirklich letzten Detail auszuarbeiten. Bei weltweiter Konkurrenz ist es unabdingbar, Dinge, die einem wichtig sind, akribisch ausarbeiten. Was mich ärgert, sind festgefahrene Strukturen, teilweise gegen Windmühlen kämpfen zu müssen, Vorurteile – wo letzten Endes die Leistung, die man erbracht hat, überhaupt nicht zählt.

Ich glaube, dass wir in Deutschland mehr Durchlässigkeit brauchen, auch in Bezug auf die Arbeitsstrukturen und die Interdisziplinarität. Ich habe während meines Sabbaticals an der Universität Stanford vergangenes Semester lernen können, wir wichtig Forschung über Fachgrenzen hinweg ist. Dort gibt es sogar ein eigens für den Zweck der interdisziplinären Forschung geschaffenes Gebäude, und ich denke, dass ein beträchtlicher Teil der großen Erfolge an dieser Universität damit zusammenhängt. Ich habe das Gefühl, dass die Öffnung für interdisziplinäre Arbeit und Forschung in Deutschland noch nicht so stark ist. Das müsste man verstärken, weil man damit sehr schnell viel erreichen kann.

Was gibt es außerhalb Ihrer Arbeit? Was tun Sie, wenn Sie sich entspannen wollen?

Prof. Dr.-Ing. Thomas Wiegand

Die Familie und der Beruf lasten mich sehr stark aus, da bleibt wenig Zeit für Hobbys. Wenn es sich mal ergibt, gehe ich Katamaransegeln und spiele Tischtennis oder Boule.

Dr.-Ing. Detlev Marpe

Bei mir ist es im Wesentlichen die Familie, für die meine freie Zeit außerhalb der Arbeit reserviert ist. Daneben gibt es noch ein kleines Hobby, das aber wiederum stark an den Beruf angelehnt ist: Ich habe mit anderen ehemaligen Kollegen vor rund zehn Jahren eine Ausgründung gemacht, die daviko GmbH. In dieser Firma entwickeln wir softwarebasierte Videokonferenzsysteme, die sich mit wenig Aufwand, quasi von jedem Laien, installieren und betreiben lassen. In diese Firma investiere ich auch einen Teil meiner Freizeit.

Dr.-Ing. Heiko Schwarz

Entspannen – im Urlaub, ja. Da unternehme ich gerne ausgedehnte Bergwanderungen, sodass ich mich mal richtig von allem löse – kein Handy, kein Telefon, kein Computer – und einfach mal abschalte, um den Kopf wieder frei zu kriegen. Ansonsten ist es die Familie, die die restliche Zeit bekommt

Gebärdensprache

Gebärdensprache

Leichte Sprache

Leichte Sprache